Der A/B-Testing Guide

Alles, was Sie über A/B-Tests wissen müssen: Vorteile, Methoden, Herausforderungen und Beispiele.

1. Was ist A/B-Testing?

Definition von A/B Testing

A/B-Testing, auch Split-Testing genannt, ist eine Methode, bei der zwei oder mehr Varianten einer Webseite, App oder eines Elements verglichen werden. Das Ziel ist es, die effektivste Variante zu ermitteln, um zu verstehen, was User sich wünschen und die Geschäftsziele (wie die Anzahl der Conversions) zu optimieren.

A/B-Testing sorgt für weniger Rätselraten bei der Website-Optimierung und mehr datengestützte Entscheidungen. Der Vergleich zwischen den zwei oder mehr Variablen hilft dabei, Fragen zu wichtigen Geschäftskennzahlen zu beantworten. Die Version, die sich positiv auf diese Kennzahlen auswirkt, ist der Gewinner des A/B-Tests.

A/B-Testing ist ein Teil des Prozesses der Conversion Rate Optimierung (CRO). Was diese Conversions darstellen, hängt vom Unternehmen ab. Bei einem E-Commerce-Shop könnte es sich um die Anzahl der Verkäufe handeln, während es bei einem B2B-Unternehmen um die gesammelten Leads gehen könnte.

Möchten Sie mehr darüber erfahren, wie Sie mit A/B-Tests die Erwartungen Ihrer Kunden erfüllen können? Downloaden Sie unser kostenloses E-Book: „Was User von Online Shops erwarten„

2. Welche Vorteile bietet A/B-Testing für verschiedene Teams?

A/B-Testing kann Ihnen dabei helfen, Entscheidungen auf der Grundlage von Daten zu treffen. Dies sieht für jedes Team anders aus und hilft ihnen auf unterschiedliche Weise. Schauen wir uns drei Szenarien an:

Marketing Teams

Besucherprobleme lösen

Besucher kommen mit einem bestimmten Ziel auf Ihre Website. Vielleicht möchten sie ein bestimmtes Produkt kaufen, mehr über ein bestimmtes Thema lernen oder einfach nur stöbern. Was auch immer das Ziel ist, sie werden möglicherweise auf einige Probleme stoßen. Es kann sich um einen verwirrenden Text handeln oder um einen schwer auffindbaren CTA-Button wie „Jetzt kaufen“, „Demo anfordern“ usw.

A/B-Tests können Marketing Teams dabei helfen, Probleme von Besuchern zu identifizieren und verschiedene Lösungen zu testen. So können sie das User-Erlebnis optimieren und die Website-Leistung auf der Grundlage des Verhaltens und Feedbacks echter User verbessern.

Verbesserter ROI aus dem bestehenden Traffic

Jeder Marketing-Mensch weiß, wie hoch die Kosten für hochwertigen Traffic sein können. A/B-Tests ermöglichen es Marketing Teams, Einblicke in die Kundenpräferenzen zu gewinnen, Kampagnen so zu optimieren und einen höheren ROI aus dem vorhandenen Traffic zu erzielen. Sogar die kleinste Änderungen können oft zu erheblichen Verbesserungen führen.

Produkt Teams

Bounce-Rate senken

Eine der wichtigsten Kennzahlen, um die Performance Ihrer Website zu bewerten, ist die Absprungrate (Bounce Rate). Es kann viele Gründe für eine hohe Bounce Rate geben, z. B. zu viele Optionen zur Auswahl, nicht erfüllte Erwartungen, verwirrende Navigation, usw. Anstatt zu raten, wo das Problem liegt, können Produkt Teams das Problem zu identifizieren und Änderungen am Design, am Inhalt oder an der Funktionalität vorzunehmen, um die User besser anzusprechen und sie länger auf der Seite zu halten.

Änderungen mit geringem Risiko vornehmen

Bevor Sie neue Product Features einführen, können Sie diese A/B-testen, um zu verstehen, ob sie wirklich bei Ihrer Website-Zielgruppe ankommen oder nicht. Wenn Sie eine Änderung auf Ihrer Website umsetzen, ohne sie zu testen , kann dies sowohl kurz- als auch langfristig nach hinten losgehen. Indem Sie Änderungen testen und dann vornehmen, können Sie das Ergebnis sicherer vorhersagen.

Growth Teams

Statistisch signifikante Ergebnisse erzielen

Growth Teams können strategische Entscheidungen gegenüber Stakeholdern rechtfertigen, indem sie die Berichte aus A/B-Tests verwenden. A/B-Tests sind vollständig datengesteuert und lassen keinen Raum für Vermutungen, Bauchgefühle oder Instinkte. Daher können Sie schnell einen „Gewinner“ und einen „Verlierer“ ermitteln, und zwar auf Grundlage statistisch signifikanter Verbesserungen.

Webseiten neu gestalten um zukünftige Einnahmen zu steigern

A/B-Tests können dabei helfen, einen kleinen CTA-Text oder eine Farbe anzupassen oder die Website komplett neu zu gestalten. Growth Teams können das Design einer Website ohne Risiko verbessern, indem sie neue Ideen schrittweise testen und ihre Auswirkungen messen. Dieser Ansatz garantiert, dass Änderungen auf Daten basieren und Verbesserungen mit den Geschäftszielen übereinstimmen.

3. Was können Sie A/B-testen?

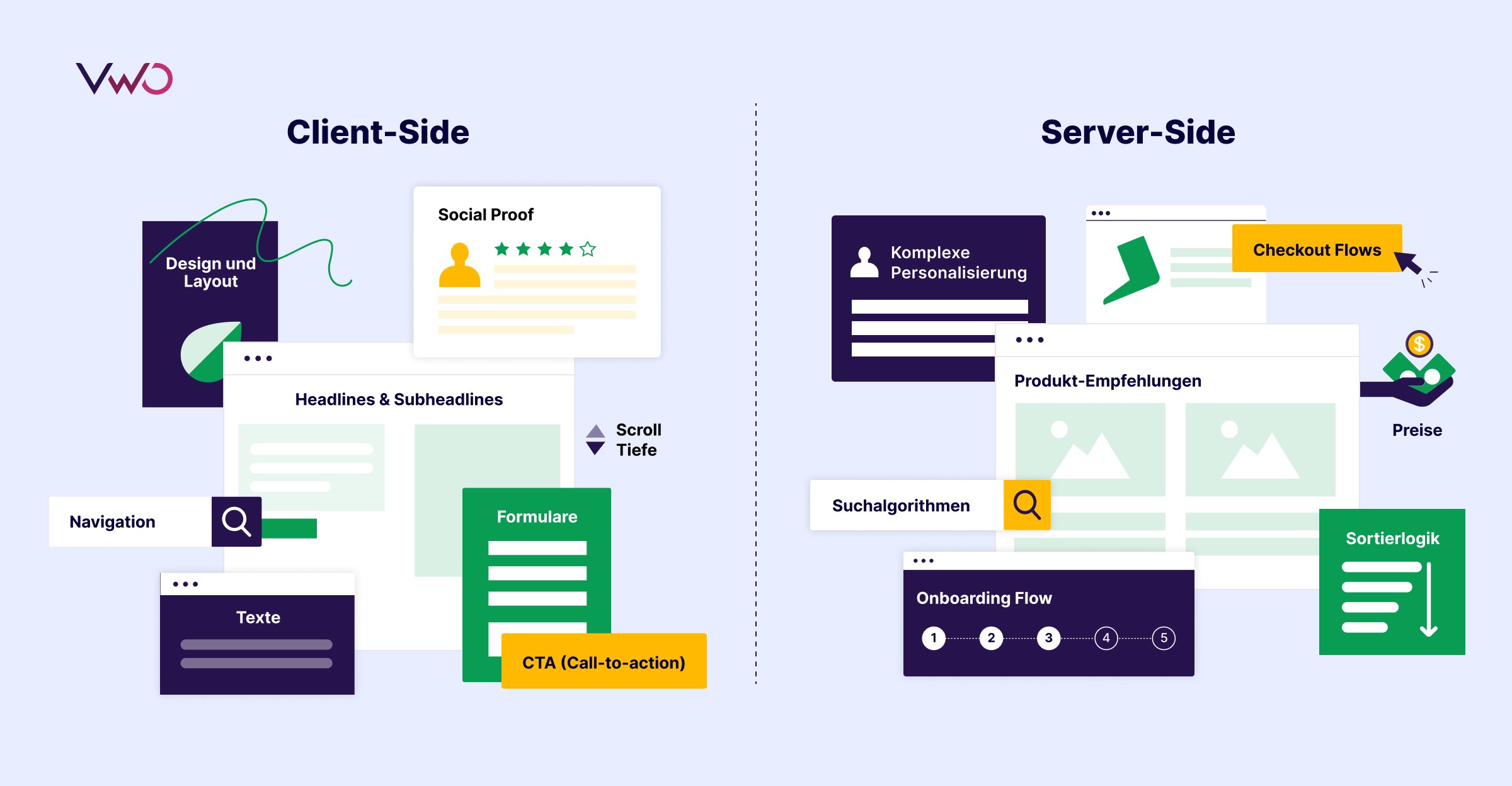

Sie können (und sollten) praktisch alles auf Ihrer Website testen, sowohl im Front-End als auch im Back-End. Hier sind einige zentrale Anwendungsfälle für client- und server-seitige Funktionen, die A/B-getestet werden können:

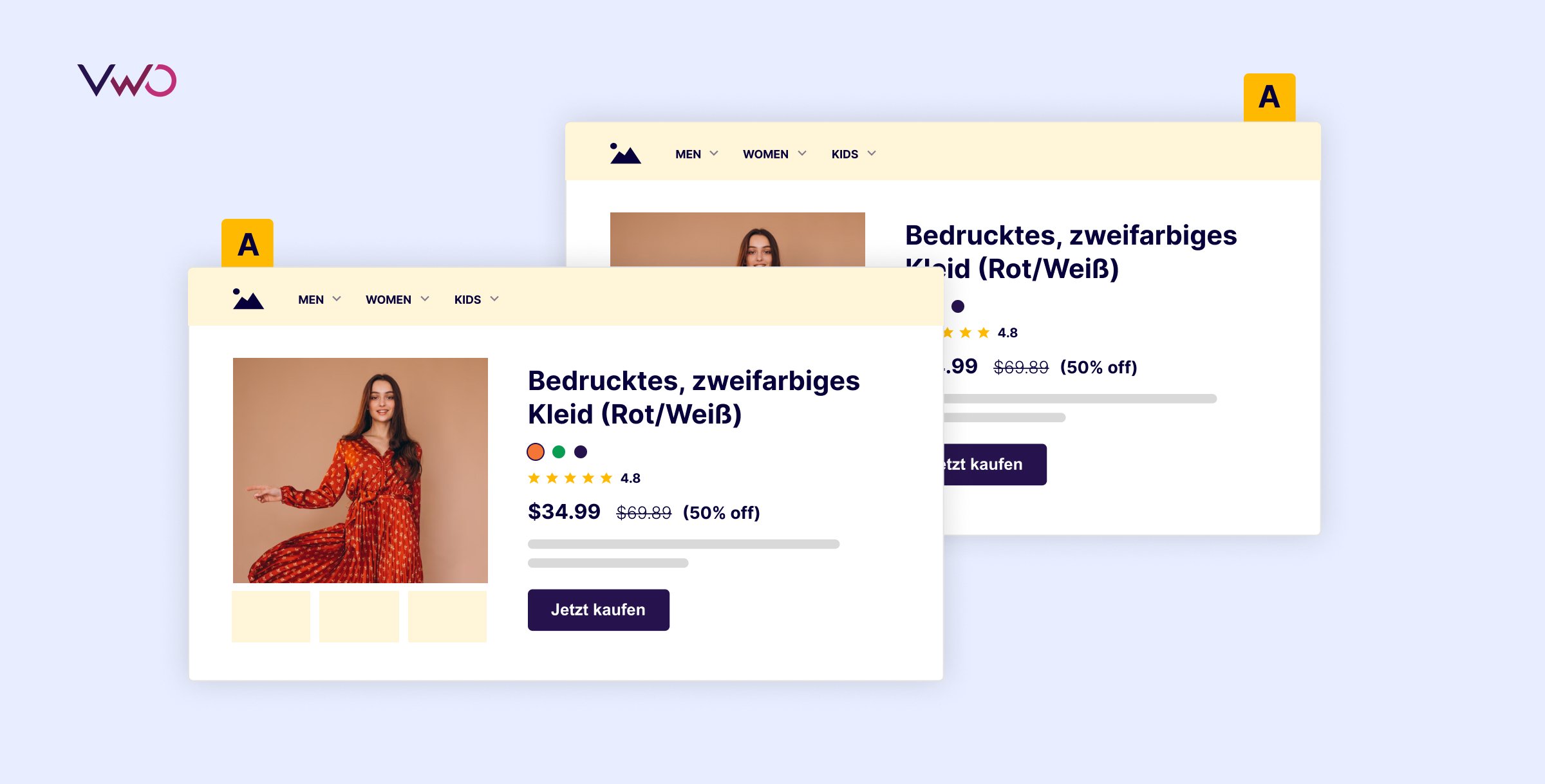

Client-Side

Beim Client-Side Testing werden Änderungen an den visuellen Elementen getestet, die User in ihrem Browser sehen und mit denen sie interagieren. Es eignet sich ideal zum Testen von UI/UX-Änderungen und Inhalten, die keine Änderungen am Backend erfordern und von nicht-technischen Teams (z. B. Marketing) mithilfe eines visuellen Editors durchgeführt werden können. Hier sind einige Elemente die Sie testen können:

- Texte

- Design und Layout

- Navigation

- Formulare

- CTA (Call-to-action)

- Social Proof

- Scroll-Tiefe

Server-Side

Server-Side Testen bezieht sich auf Änderungen an der Backend-Logik oder -Infrastruktur, wie z. B. das Testen neuer Algorithmen, die Einführung von Funktionen oder Personalisierung. Es eignet sich am besten für Experimente, die Datenverarbeitung, dynamische Inhaltsbereitstellung oder nahtlose Ausführung auf verschiedenen Geräten erfordern. Hier sind einige Beispiele für Funktionen, die auf der Server-Side getestet werden können:

- Produkt-Empfehlungen

- Preise

- Sortierlogik

- Suchalgorithmen

- Checkout flows

- Komplexe Personalisierung

4. A/B-Testing Beispiele

Da wir nun wissen, was wir testen können, sehen wir uns an, wie dies in der Praxis aussehen würde.

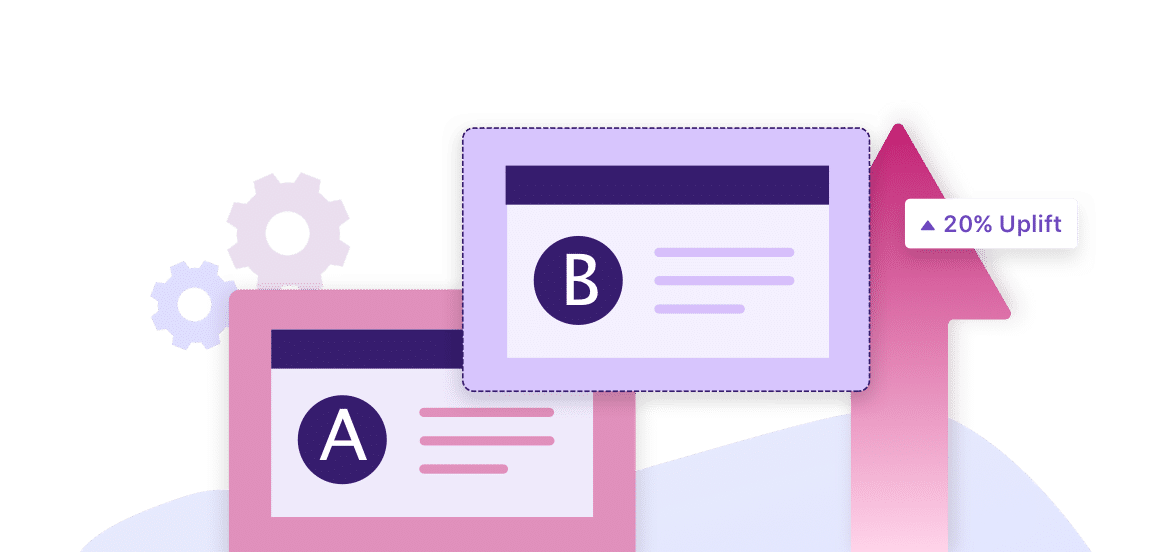

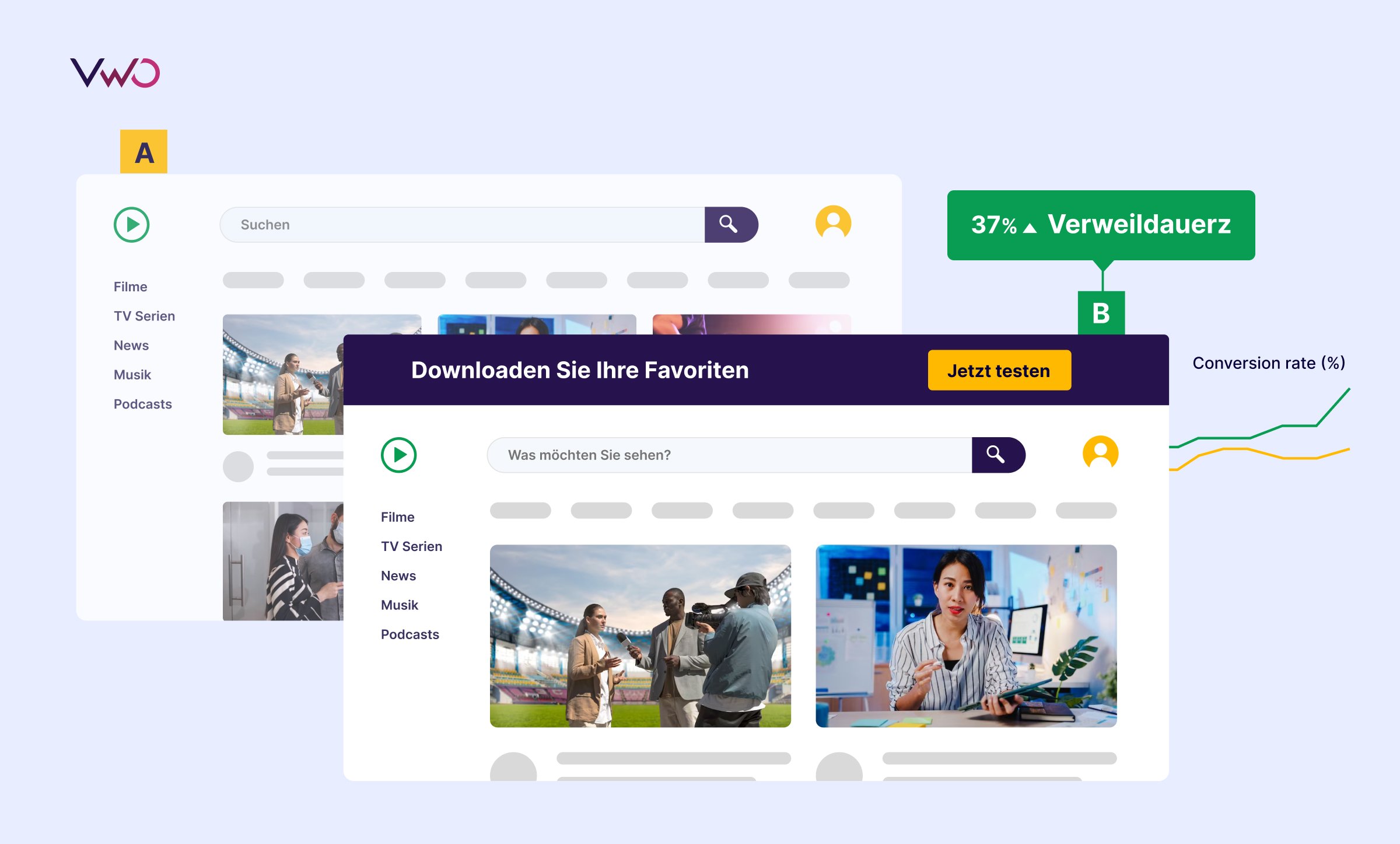

A/B-Testing Beispiel (Client-Side): Die Verweildauer auf einer Streaming-Plattform verbessern

Bei diesem A/B-Test wurden in der Variante (Version B) zwei zentrale Änderungen vorgenommen. Zunächst wurde oben ein Banner hinzugefügt, das die Besucher dazu auffordert, sich für eine kostenlose Testversion anzumelden, und sie daran erinnert, dass die Inhalte zur Offline-Ansicht heruntergeladen werden können. Zweitens wurde der Text im Suchfeld von „Suchen“ in „Was möchten Sie sehen?“, geändert, um ein persönlicheres Erlebnis zu schaffen. Diese Anpassungen führten zu einer 37-prozentigen Steigerung der Verweildauer, was Version B zum klaren Gewinner macht.

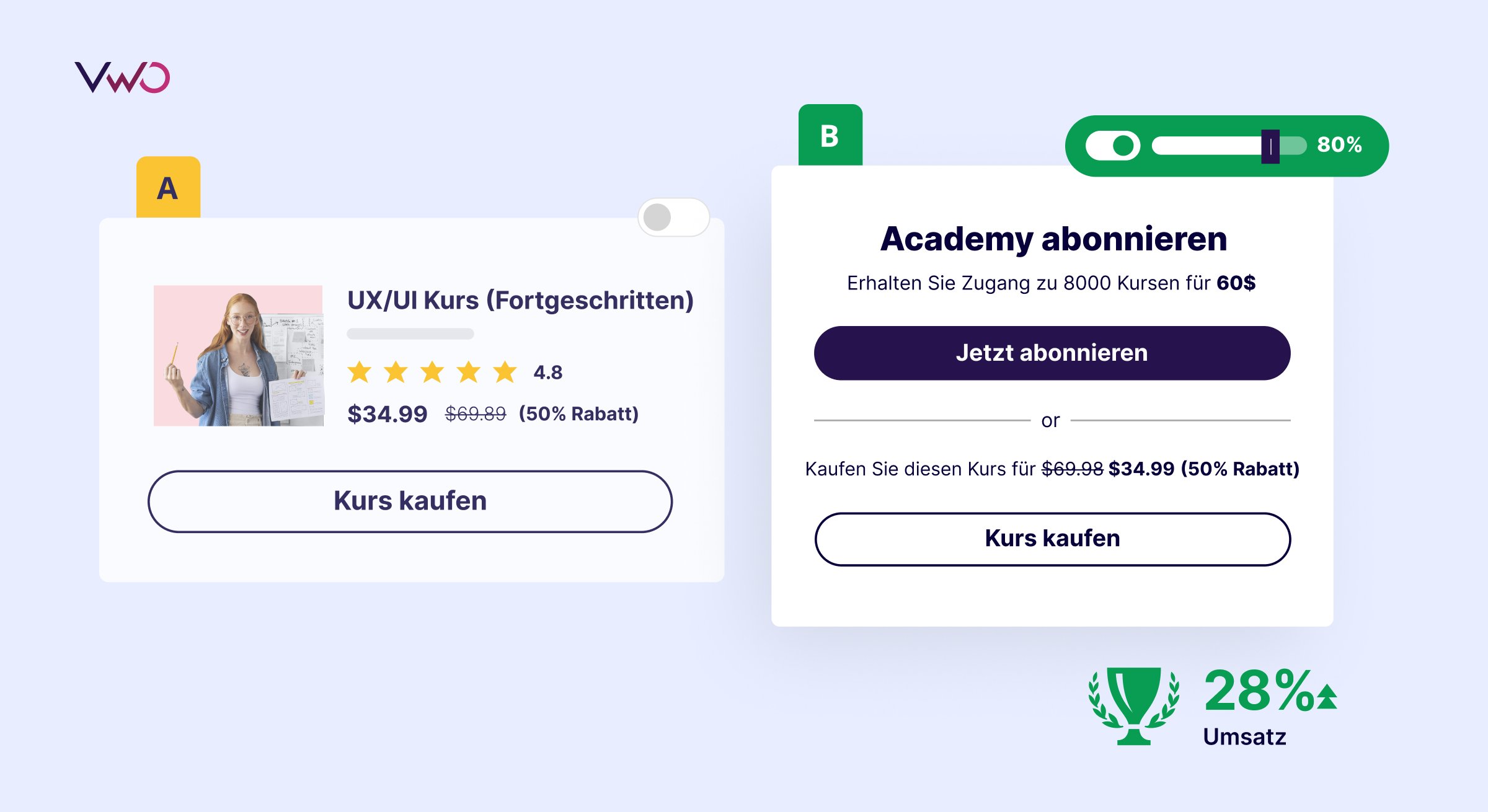

A/B-Testing Beispiel (Sever-Side): Ein Rabatt im Vergleich zu einem Abonnement

In diesem Beispiel für einen Server-Side Test erforschen was passiert, wenn wir zusätzlich zu dem bestehenden 50 % Rabatt-Angebot eine Abonnement-Option einführen. Das Ziel ist es, festzustellen, ob die zusätzliche Option zu mehr Engagement und Umsatz führt. Die Ergebnisse sind eindeutig: Die Variante mit der Abonnement-Option führt zu einer deutlichen Umsatzsteigerung von 28 %.

Weitere Beispiele finden Sie in den Erfolgsgeschichten unserer Kunden. Lassen Sie sich von ihnen inspirieren oder buchen Sie eine Demo, um ein Beispiel auf Ihrer eigenen Website zu sehen.

5. Arten von A/B-Tests

Es gibt einige Arten oder Variationen von A/B-Tests. Die häufigsten sind die folgenden:

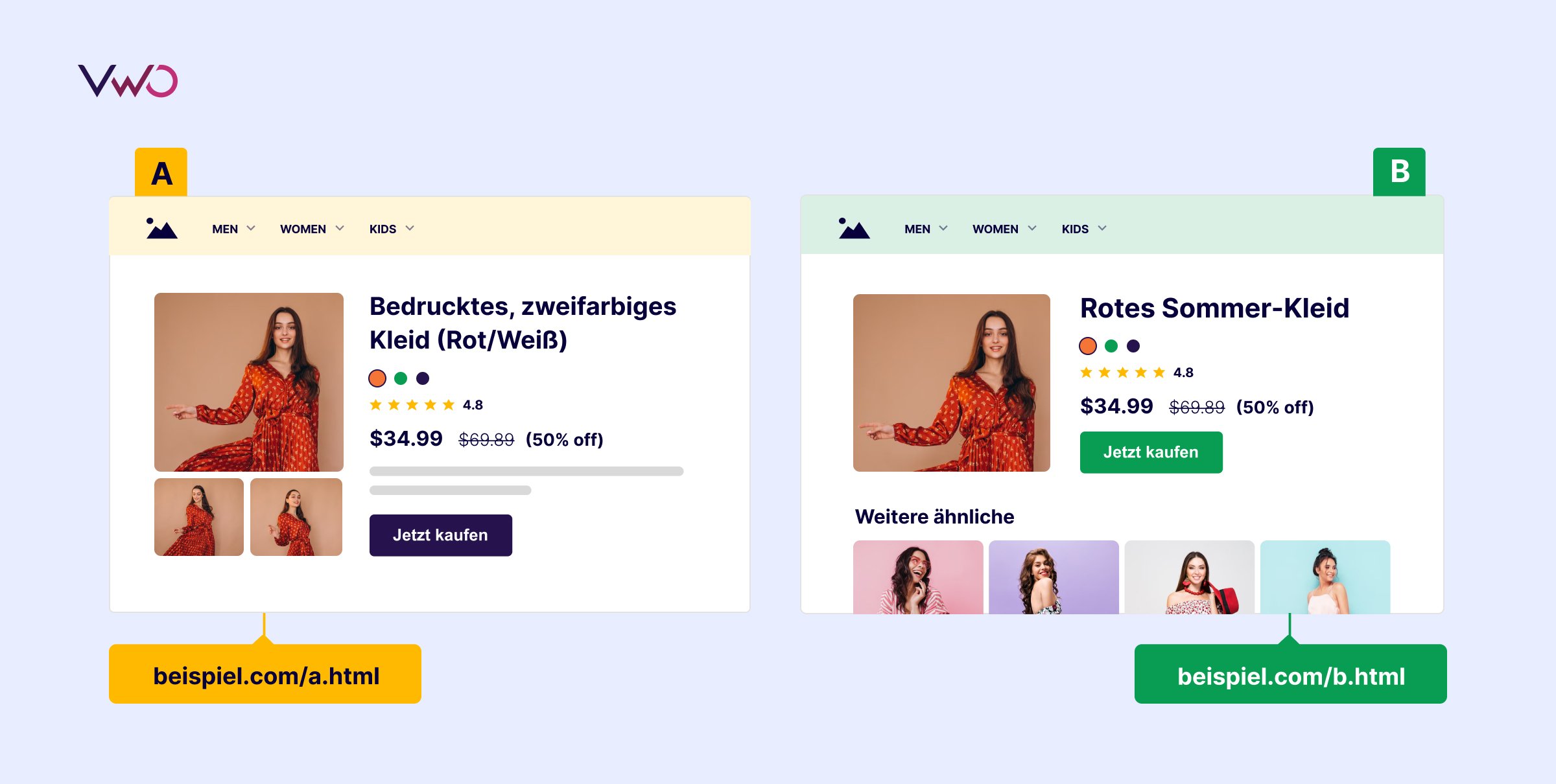

Split-URL-Tests

Viele Menschen verwechseln Split-URL-Tests mit A/B-Tests. Die beiden haben jedoch durchaus ihre Unterschiede. Split-URL-Tests beziehen sich auf einen Experiment-Prozess, bei dem eine völlig neue Version einer bestehenden Website-URL getestet wird, um zu analysieren, welche Version besser abschneidet.

Bei A/B-Tests werden dagegen verschiedene Elemente auf einer Website verglichen, ohne dass eine völlig neue URL erstellt wird. Split-URL-Tests werden in der Regel für komplexere Änderungen verwendet, wie z. B. eine vollständige Neugestaltung des Designs einer Marke.

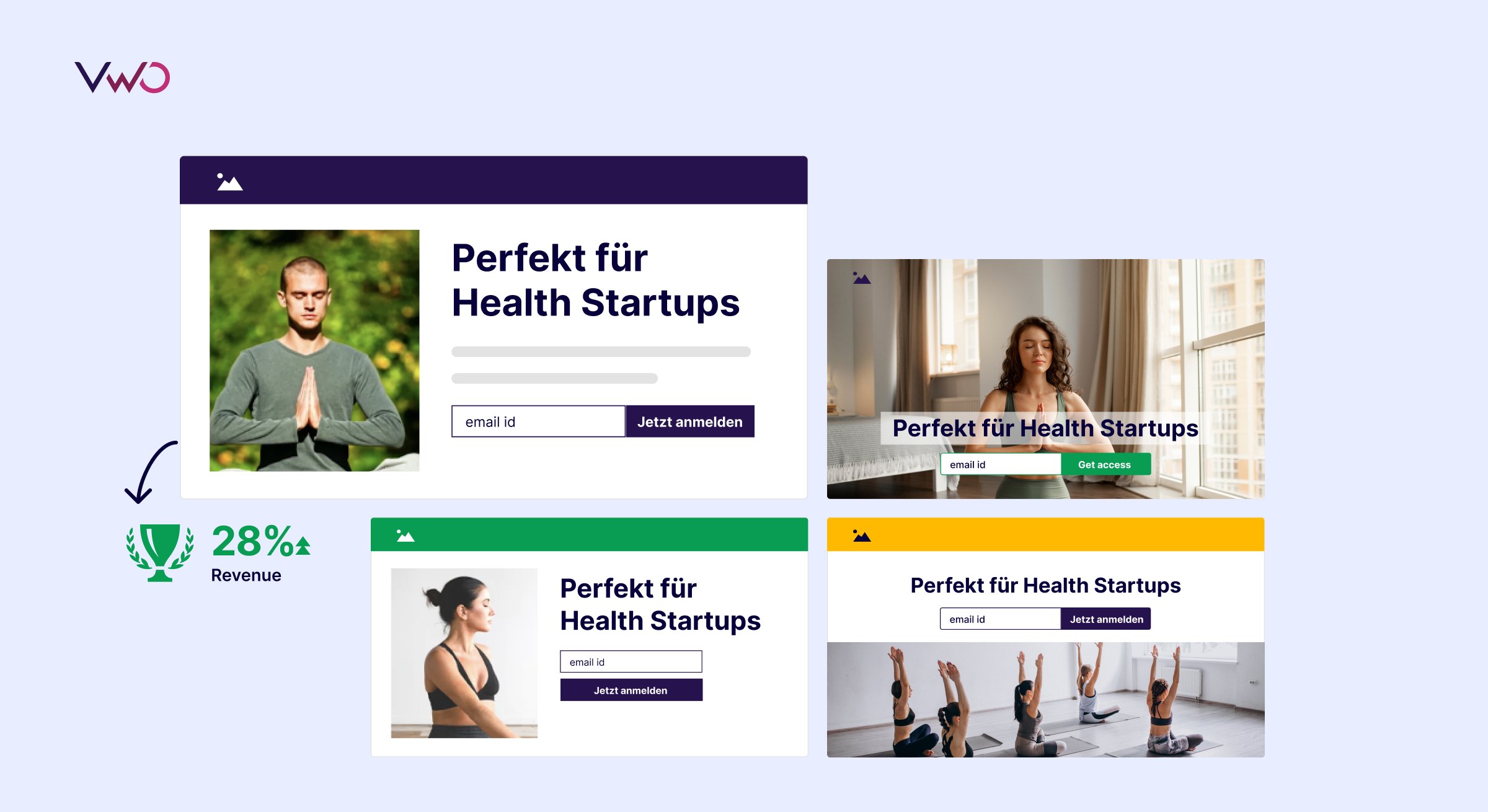

Multivariate Tests

Multivariate Tests (MVT) sind Tests, bei denen Variationen mehrerer Variablen gleichzeitig getestet werden, um zu analysieren, welche Kombination von Variablen die beste Leistung erzielt.

Nehmen wir an, Sie möchten zwei Versionen eines Bildes, die Farbe eines Call-to-Action-Buttons und die Überschriften einer Ihrer Landing Pages testen. Ein Multivarite Test erstellt automatisch 8 Versionen der Seite mit allen möglichen Kombinationen von Änderungen, um festzustellen, welche die von Ihnen verfolgte Metrik verbessert. Sie müssen nicht alle acht Seiten selbst konfigurieren.

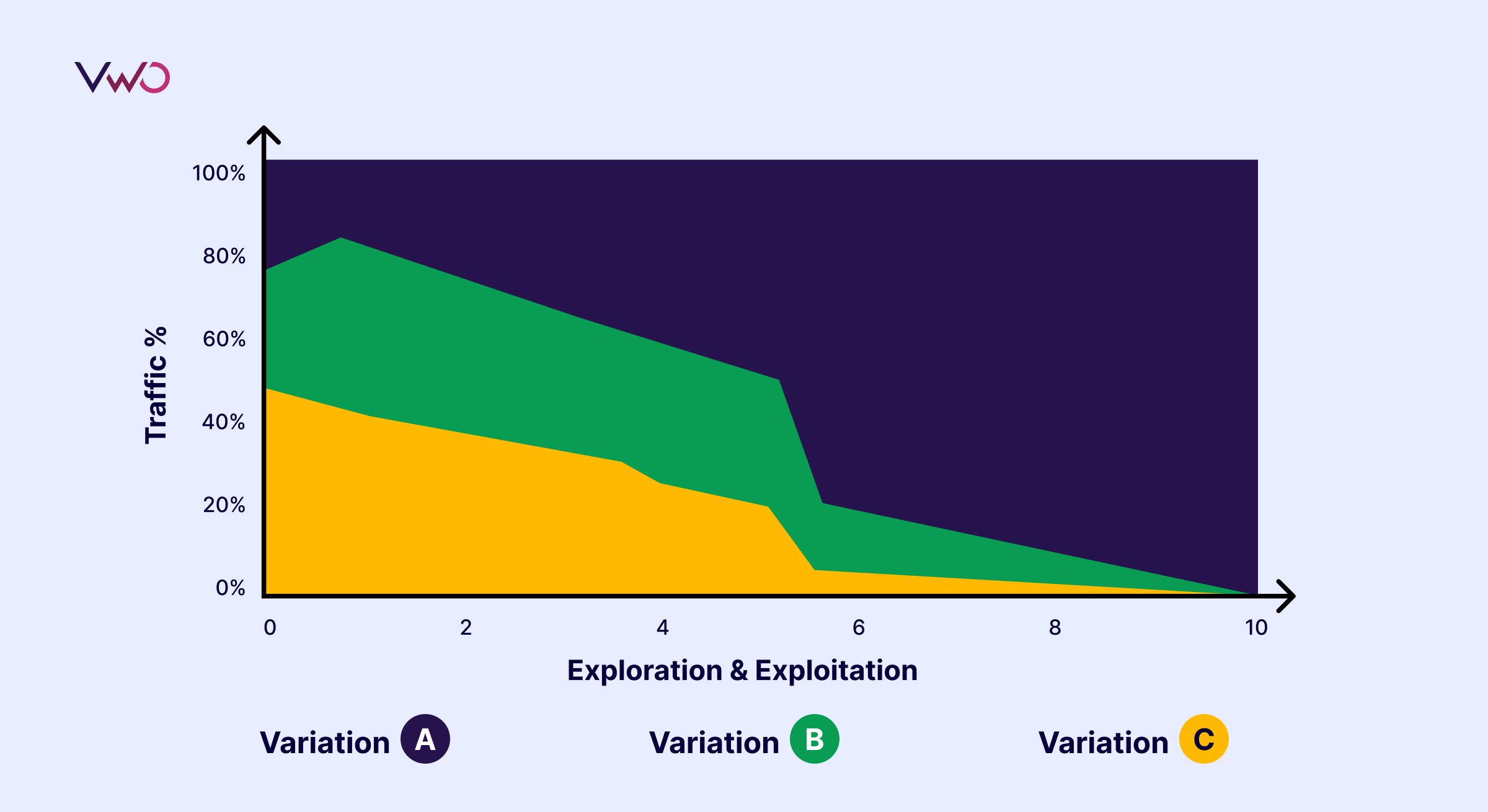

Multi-Armed-Bandit Test

Im Vergleich zu einem konventionellen A/B-Test muss bei einem Multi-Armed-Bandit-Test nicht gewartet werden, bis das Experiment abgeschlossen ist, um den Traffic auf die Gewinner-Version zu leiten. In diesem Fall wird der Traffic dynamisch und zunehmend der Version zugewiesen, die mehr Conversions aufweist.

A/A Tests

Bei einem A/A-Test wird ein Element von zwei identischen Seiten verglichen. Anstatt eine Steigerung der Conversions zu ermitteln, besteht das Ziel eines A/A-Tests darin, zu überprüfen, dass es keinen Unterschied zwischen Ihrer Kontroll- und Ihrer Variationsversion gibt. „Was soll das bringen?“, fragen Sie sich vielleicht. A/A-Tests werden häufig verwendet, um das eingesetzte Testing-Tool zu bewerten oder Fehler zu identifizieren, die sich auf die Ergebnisse von A/B-Tests auswirken könnten.

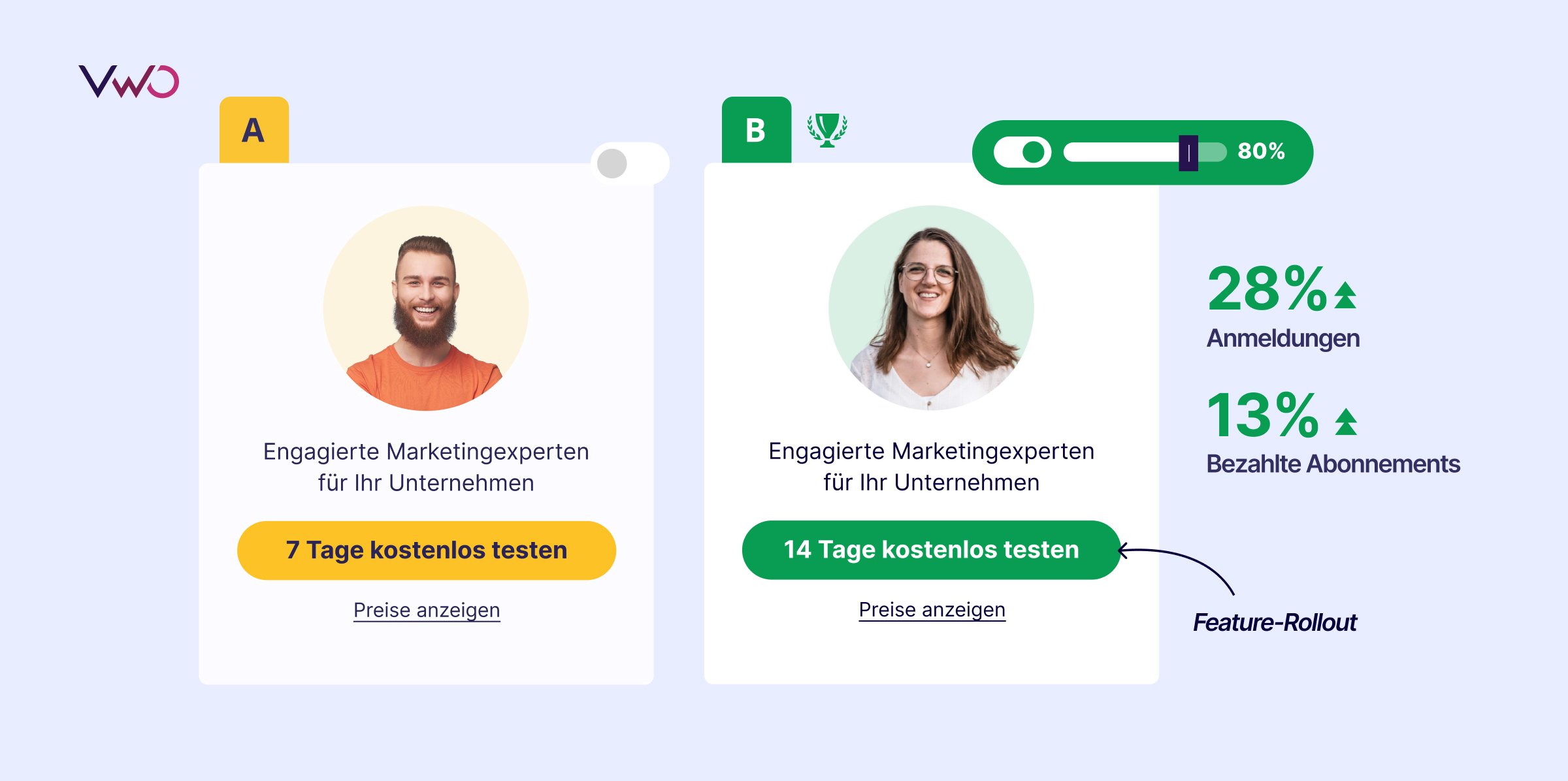

Feature-Tests

Feature-Tests werden durchgeführt, wenn eine neue Funktion in eine Anwendung eingeführt oder eine vorhandene Funktion geändert wird. Sie können auch als Prozess definiert werden, bei dem mehrere Iterationen der Funktion getestet werden, um die erfolgreichste Version der Funktion zu ermitteln, die das beste User-Erlebnis bietet.

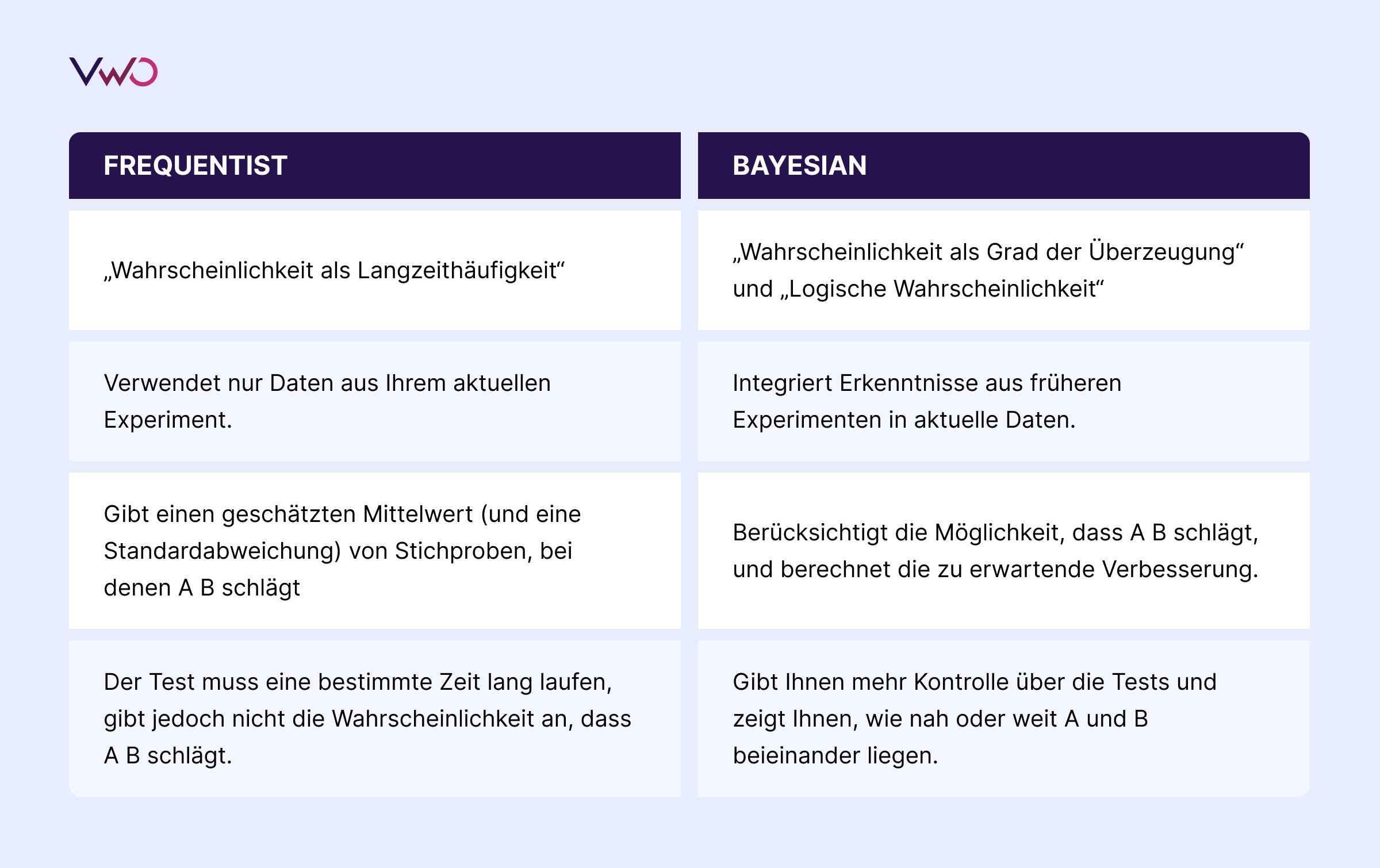

6. Welcher statistische Ansatz wird in einem A/B Test verwendet?

Es ist wichtig zu verstehen, welcher statistische Ansatz gewählt werden muss, um einen A/B-Test erfolgreich durchzuführen und die richtigen geschäftlichen Schlussfolgerungen zu ziehen.

Generell gibt es zwei statistische Ansätze, die für A/B-Tests verwendet werden: Frequentist und Bayesian. Beide Ansätze haben ihre eigenen Vor- und Nachteile. Wir bei VWO verwenden, empfehlen jedoch den Bayesian-Ansatz.

Der unten aufgeführte Vergleich zwischen den beiden Ansätzen soll Ihnen helfen zu verstehen, warum.

7. Wie sieht ein A/B-Test Prozess aus?

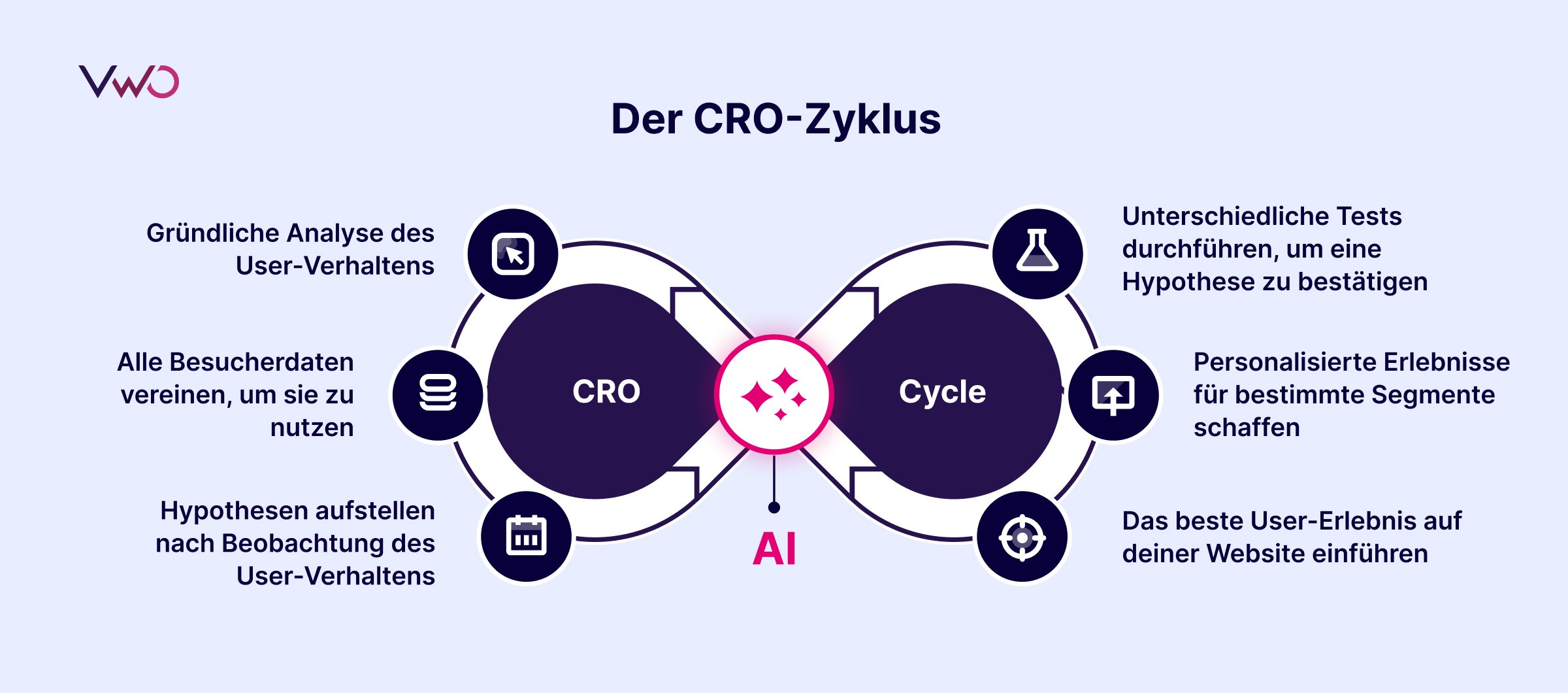

A/B-Tests sollten nie als isolierte Optimierungsübung betrachtet werden. Sie sind Teil eines größeren, ganzheitlichen CRO-Zyklus und sollten auch als solche behandelt werden. Ein effektiver A/B-Test- oder CRO-Zyklus besteht in der Regel aus 6 Teilen.

Werfen Sie einen Blick auf diesen Ausschnitt aus unserem Webinar mit Engin Diren, in dem er die Einrichtung eines A/B-Test-Workflows erklärt. Das vollständige Webinar können Sie hier downloaden.

1. Gründliche Analyse des User-Verhaltens

Diese Phase ist die Planungsphase Ihres A/B-Testprogramms. Es geht um die Messung der Leistung Ihrer Website und wie Besucher darauf reagieren. In dieser Phase sollten Sie in der Lage sein, herauszufinden, was auf Ihrer Website passiert, warum es passiert und wie Besucher darauf reagieren. Tools wie Heatmaps, Session Recordings und Umfragen sind dabei unverzichtbar.

2. Alle Besucherdaten vereinen, um sie zu nutzen

Sobald die Daten erfasst sind, ist es Zeit, Beobachtungen aufzuzeichnen und mit der Planung Ihrer Kampagne zu beginnen. Bessere Daten bedeuten höhere Umsätze.

Sobald die Geschäftsziele definiert, die KPIs festgelegt und die Daten der Website und das Besucherverhalten analysiert sind, ist es Zeit, einen Backlog zu erstellen. Ihr Backlog sollte eine umfassende Liste aller Elemente auf der Website sein, die Sie basierend auf den analysierten Daten testen möchten.

3. Hypothesen aufstellen

Sie können jetzt damit beginnen, datengestützte Hypothesen zu erstellen. Nehmen wir zum Beispiel an, Sie analysieren die Daten, die in der ersten Phase mithilfe quantitativer und qualitativer Research-Tools gesammelt wurden, und kommen zu dem Schluss, dass fehlende Zahlungsoptionen dazu führen, dass die meisten potenziellen Kunden den Kaufvorgang auf der Checkout-Seite abbrechen. Sie stellen also die Hypothese auf, dass „das Hinzufügen mehrerer Zahlungsoptionen dazu beitragen wird, die Abbruchrate auf der Checkout-Seite zu reduzieren“.

Um Ihre Hypothesen zu priorisieren, können Sie das CIE-Framework verwenden. In diesem Framework gibt es drei Parameter, nach denen Sie Ihren Test auf einer Skala von 1 bis 5 bewerten müssen:

Vertrauen: Wie sicher sind Sie, dass Sie die erwartete Verbesserung durch die Hypothese erreichen?

Wichtigkeit: Wie wichtig ist der Test (für den die Hypothese erstellt wird)?

Leichtigkeit: Wie schwierig wird es sein, die für den Test ermittelten Änderungen umzusetzen?

Wenn Sie beim Brainstorming mal keine neue Testideen haben, machen Sie sich keine Sorgen – VWO hat eine Lösung für Sie. Sie können jetzt innerhalb weniger Minuten AI-generierte Testideen erhalten.

4. Unterschiedliche Tests durchführen um eine Hypothese zu bestätigen

Die vierte und wichtigste Phase ist die Testphase. Jetzt verfügen Sie über alle erforderlichen Daten und einen priorisierten Backlog. Sobald Sie Hypothesen formuliert haben, die mit Ihrem Ziel übereinstimmen, und diese priorisiert haben, erstellen Sie Variationen und starten Sie den Test. Stellen Sie während der Testphase sicher, dass alle Anforderungen erfüllt sind, um vor Abschluss statistisch signifikante Ergebnisse zu erzielen, z. B. Testen auf genauen Datenverkehr, Testen nicht zu vieler Elemente zusammen, Testen auf die richtige Dauer usw.

5. Personalisierte Erlebnisse für bestimmte Segmente schaffen

Bei der Analyse der Testergebnisse ist es wichtig, das Verhalten verschiedener User-Segmente zu beobachten. Vielleicht hat Ihre Testvariante insgesamt verloren, aber für angemeldete User auf einem Smartphone war die Änderung ein Erfolg. Dies ist eine Chance, das Erlebnis für diese User-Gruppe zu personalisieren.

6. Das beste User-Erlebnis auf Ihrer Website einführen

Die Analyse der Ergebnisse äußerst wichtig. Da A/B-Tests eine kontinuierliche Datenerfassung und -analyse erfordern, wird in diesem Schritt Ihre gesamte Kampagne ausgewertet. Analysieren Sie nach Abschluss Ihres Tests die Testergebnisse, indem Sie Kennzahlen wie prozentuale Steigerung, Konfidenzniveau, direkte und indirekte Auswirkungen auf andere Kennzahlen usw. berücksichtigen. Wenn der Test erfolgreich ist, setzen Sie die siegreiche Variante ein, nachdem Sie diese Zahlen berücksichtigt haben. Wenn der Test nicht eindeutig ist, ziehen Sie Erkenntnisse daraus und setzen Sie diese in Ihren nachfolgenden Tests um.

8. Häufige Fehler beim A/B-Testing

A/B-Tests sind eine der effektivsten Methoden, um Geschäftsmetriken in eine positive Richtung zu lenken und die Einnahmen zu steigern. Wie bereits erwähnt, erfordern A/B-Tests jedoch Planung, Geduld und Präzision. Durch kleine Fehler können Zeit und Geld verloren gehen. Um dies zu vermeiden, finden Sie hier eine Liste der häufigsten Fehler, die bei der Durchführung eines A/B-Tests auftreten können:

Kein Testing-Roadmap planen

Ein effizienter Testing-Roadmap fängt mit guten Hypothesen an. Alle weiteren Schritte hängen davon ab: Was sollte geändert werden, warum sollte es geändert werden, was ist das erwartete Ergebnis und so weiter. Wenn Sie mit der falschen Hypothese beginnen, sinkt die Wahrscheinlichkeit, dass der Test erfolgreich ist.

Oft sind wir versucht, einfach etwas zu testen, das bei jemand anderem funktioniert hat. Sicher, jemand anderes hat seinen Sign-up-Flow geändert und eine Steigerung der Conversions um 30 % gesehen. Aber es ist ihr Testergebnis, basierend auf ihrem Traffic, ihrer Hypothese und ihren Zielen. Keine zwei Websites sind gleich – was für andere funktioniert hat, muss nicht unbedingt auch für Sie funktionieren. Der Traffic ist anders, die Zielgruppe ist möglicherweise eine andere, die Optimierungsmethode war vielleicht eine andere als Ihre usw.

Die falsche Test-Dauer

Je nach Traffic und Zielsetzung müssen Sie A/B-Tests über einen bestimmten Zeitraum durchführen, um statistische Signifikanz zu erreichen. Ein zu langer oder zu kurzer Testzeitraum kann dazu führen, dass der Test fehlschlägt oder unbedeutende Ergebnisse liefert. Sollte eine Version Ihrer Website in den ersten Tagen nach Beginn des Tests zu gewinnen scheinen, bedeutet dies nicht, dass Sie den Test vorzeitig abbrechen sollten. Eine Kampagne zu lange laufen zu lassen, ist ebenfalls ein häufiger Fehler, den Unternehmen begehen. Die Dauer des Tests hängt von verschiedenen Faktoren ab, wie z. B. dem bestehenden Traffic, der bestehenden Conversion Rate, der erwarteten Verbesserung usw.

Erfahren Sie, wie lange Sie Ihren Test laufen lassen sollten.

Das falsche Tool verwenden

Da A/B-Tests immer beliebter werden, sind auch mehrere kostengünstige Tools auf den Markt gekommen. Nicht alle dieser Tools sind gleich gut. Einige Tools verlangsamen Ihre Website drastisch, während andere nicht die erforderlichen qualitativen Tools (Heatmaps, Session Recordings usw.) haben, was zu fehlerhaften Daten führt. A/B-Tests mit solchen Tools können den Erfolg Ihres Tests verlangsamen.

Externer Faktoren nicht berücksichtigen

Um aussagekräftige Ergebnisse zu erzielen, sollten Tests in vergleichbaren Zeiträumen stattfinden. Beispielsweise kennen Online-Shops den Unterschied zwischen Traffic im Frühling (normal) mit dem der Vorweihnachtszeit (sehr hoch). Ein und derselbe Test würde je nach Zeitraum aufgrund des externen Faktors Weihnachten zu unterschiedlichen und wahrscheinlich verfälschten Ergebnissen führen. Verwenden Sie den A/B-Test-Signifikanzrechner von VWO, um herauszufinden, ob die Ergebnisse Ihres Tests signifikant sind oder nicht.

Keinen iterativen Prozess folgen

A/B-Tests sind ein iterativer Prozess, bei dem jedes Experiment auf den Ergebnissen des vorherigen aufbaut. Viele Unternehmen geben A/B-Tests auf, nachdem ihr erster Test fehlgeschlagen ist. Um jedoch die Erfolgschancen des nächsten Tests zu erhöhen, sollten Sie bei dessen Planung und Durchführung die Erkenntnisse aus den letzten Tests nutzen. Dies erhöht die Wahrscheinlichkeit, dass Ihr Test statistisch signifikante Ergebnisse liefert.

Außerdem sollten Sie nach einer erfolgreichen Testkampagne nicht einfach aufhören. Testen Sie jedes Element mehrfach, um zu immer besseren Versionen zu gelangen.

9. A/B-Testing und SEO

Was die Auswirkungen von SEO auf A/B-Tests betrifft, hat Google in seinem Blog-Beitrag mit dem Titel „Website Testing And Google Search“ Klarheit geschaffen. Die wichtigsten Punkte aus diesem Beitrag finden Sie hier zusammengefasst:

Kein Cloaking

Cloaking – das Anzeigen einer Reihe von Inhalten für Menschen und einer anderen für Googlebot – verstößt gegen unsere Webmaster-Richtlinien, unabhängig davon, ob Sie einen Test durchführen oder nicht. Achten Sie darauf, dass Sie nicht anhand des User-Agents entscheiden, ob Sie den Test durchführen oder welche Inhaltsvariante Sie verwenden. Ein Beispiel hierfür wäre, immer den Originalinhalt bereitzustellen, wenn Sie den User-Agent „Googlebot“ sehen. Denken Sie daran, dass ein Verstoß gegen unsere Richtlinien dazu führen kann, dass Ihre Website in den Google-Suchergebnissen herabgestuft oder sogar entfernt wird – wahrscheinlich nicht das gewünschte Ergebnis Ihres Tests.

Verwenden Sie nur 302-Redirects

Wenn Sie einen A/B-Test durchführen, bei dem User von der ursprünglichen URL auf eine Variations-URL umgeleitet werden, verwenden Sie ein 302-Redirect (temporär) und keinen 301-Redirect (permanent). Dies teilt den Suchmaschinen mit, dass diese Weiterleitung nur vorübergehend ist – sie wird nur so lange bestehen, bis Sie das Experiment abgeschlossen haben – und dass sie die ursprüngliche URL in ihrem Index behalten sollten, anstatt sie durch die Testseite zu ersetzen. Auch JavaScript-basierte Weiterleitungen haben von Google grünes Licht erhalten.

Führen Sie Experimente für die angemessene Dauer durch

Die für einen zuverlässigen Test erforderliche Zeit hängt von verschiedenen Faktoren ab, wie z. B. Ihren Conversion-Raten und dem Traffic auf Ihrer Website. Ein gutes Testtool sollte Ihnen mitteilen, wann Sie genügend Daten gesammelt haben, um zuverlässige Schlussfolgerungen ziehen zu können. Sobald Sie den Test abgeschlossen haben, sollten Sie Ihre Website mit den gewünschten Varianten aktualisieren und alle Elemente des Tests so schnell wie möglich entfernen, z. B. alternative URLs oder Testskripte und Markup.

Verwenden Sie „rel=“canonical„-Links

Google empfiehlt die Verwendung des Link-Attributs ‚rel=‘canonical“ für alle alternativen URLs, damit Sie hervorheben können, dass die originale URL die bevorzugte ist. Dieser Vorschlag beruht auf der Tatsache, dass „rel=“canonical“ im Vergleich zu anderen Methoden wie dem Meta-Tag ‚no index‘ in dieser Situation besser zu Ihrer Absicht passt. Wenn Sie beispielsweise Varianten Ihrer Produktseite testen, möchten Sie nicht, dass Suchmaschinen Ihre Produktseite nicht indizieren. Sie möchten lediglich, dass sie verstehen, dass alle Test-URLs enge Duplikate oder Varianten der Original-URL sind und zusammen gruppiert werden sollten, wobei die Original-URL im Vordergrund steht. In solchen Fällen kann die Verwendung von „no index“ anstelle von „rel=“canonical“ manchmal unerwartete negative Auswirkungen haben.

10. A/B Testing Tools

Der Markt für A/B-Testtools ist in den letzten Jahren erheblich gewachsen. Hier sind einige der beliebtesten Tools. In diesem Blogbeitrag finden Sie einen vollständigen Vergleich aller ihrer Funktionen.

- VWO

- Google Optimize (Nicht mehr verfügbar, aber die Migration zu VWO dauert nur 30 Sekunden)

- Optimizely

- AB Tasty

- Adobe Target

- Dynamic Yield

- Kameleoon

Fazit: Probieren Sie es einfach aus.

Wenn Sie es bis hierher geschafft haben, sollten Sie jetzt praktisch ein A/B-Test Experte sein. Aber A/B-Tests sind, wie viele andere Disziplinen auch, ein Handwerk, bei dem man durch Übung lernt. Vielleicht haben Sie bereits einige Ideen, die Sie testen wollten, oder vielleicht hat Sie dieser Artikel dazu inspiriert, etwas auszuprobieren. So oder so, wir zeigen Ihnen gerne, wie einfach es ist, Ihre Ideen mit VWO in die Praxis umzusetzen. Melden Sie sich für unsere kostenlose Testversion an oder lassen Sie sich die Plattform einfach in einer Demo zeigen. Sie brauchen noch mehr Inspiration? Laden Sie unser eBook „Was User von Online-Shops erwarten“ herunter und finden Sie Ihre nächste A/B-Testidee. Viel Spaß beim Testen!

Häufig gestellte Fragen zu A/B-Tests

A/B-Testing, auch Split-Testing genannt, ist eine Methode, bei der zwei oder mehr Varianten einer Webseite, App oder eines Elements verglichen werden. Das Ziel ist es, die effektivste Variante zu ermitteln.

Im digitalen Marketing ist A/B-Testing der Prozess, bei dem zwei Versionen derselben Webseite gleichzeitig verschiedenen Segmenten von Website-Besuchern gezeigt werden und dann verglichen wird, welche Version die Conversion Rate verbessert.

Es gibt verschiedene Gründe, warum wir A/B-Tests durchführen: User-Probleme beseitigen, Conversion Rate erhöhen, mehr Leads generieren, Absprungrate senken usw.

Bei A/B-Tests wird der Traffic auf zwei oder mehr völlig unterschiedliche Versionen einer Webseite aufgeteilt. Bei multivariaten Tests werden mehrere Kombinationen einiger Schlüsselelemente einer Seite gegeneinander getestet, um herauszufinden, welche Kombination für das Ziel des Tests am besten geeignet ist.