Síganos y manténgase al día en temas CRO.

Read summarized version with

1. ¿Qué es el A/B testing?

Definición de A/B testing

Las pruebas A/B o A/B testing, también conocidos como split testing, son un método en el que se comparan dos o más variantes de una página web, aplicación o elemento. El objetivo es determinar la variante más eficaz para entender lo que quieren los usuarios y optimizar los objetivos empresariales (como el número de conversiones).

Los tests A/B evitan las adivinanzas en la optimización de un sitio web porque permiten tomar decisiones más basadas en datos. Comparar dos o más variables, de hecho, ayuda a responder preguntas sobre métricas empresariales clave. La versión que tiene un impacto positivo en estas métricas es la ganadora del test A/B.

Evidentemente, el A/B testing forma parte del proceso de optimización de la tasa de conversión (CRO). Lo que representan estas conversiones depende de la empresa. Por ejemplo, para una tienda de comercio electrónico, puede ser el número de ventas; sin embargo, para una empresa B2B pueden ser los clientes potenciales captados.

¿Quieres saber más sobre lo que los usuarios esperan de las tiendas online y cómo puedes satisfacer sus expectativas con los tests A/B? Descarga nuestro libro electrónico gratuito: «Lo que los usuarios esperan de las tiendas online».

2. ¿Cómo funciona un test A/B o prueba A/B?

Durante un test A/B o una prueba A/B, la mitad de los visitantes de tu página web verán una versión (la versión A) y la mitad verán otra (la versión B). Por ejemplo, si tu objetivo es que más visitantes se registren para una prueba gratuita, podrías poner el botón de registro en rojo en la versión A y en azul en la versión B.

Además, también podrías pobrar diferentes posiciones del botón en el mismo test. Por ejemplo:

- Versión A: Botón rojo en la parte superior derecha

- Versión B: Botón rojo en la parte superior izquierda

- Versión C: Botón azul en la parte superior derecha

- Versión D: Botón azul en la parte superior izquierda

La versión que más aumente el porcentaje de registros será la ganadora.

3. ¿Qué ventajas tiene el A/B testing para diferentes equipos?

Los Tests A/B pueden ayudarte a tomar decisiones basadas en datos. Esto beneficia a diferentes equipos de distintas maneras. A continuación, echemos un vistazo a tres casos:

Equipos de Marketing

Resolver problemas de usuarios

Los visitantes llegan a tu sitio web con un objetivo concreto. Quizá quieran comprar un producto específico, aprender más sobre un tema determinado o simplemente curiosear. Sin embargo, sea cual sea el objetivo, pueden encontrarse con algunos problemas. Puede ser un texto confuso o un botón CTA difícil de encontrar como «Comprar ahora», «Solicitar una demostración», etc.

Así, los tests A/B pueden ayudar a los equipos de marketing a identificar los problemas de los visitantes y probar diferentes soluciones. Esto les permite optimizar la experiencia del usuario y mejorar el rendimiento del sitio web basándose en el comportamiento y los comentarios de usuarios reales.

ROI mejorado del tráfico existente

Todo responsable de marketing sabe lo elevado que puede ser el coste del tráfico de calidad. Por ello, los tests A/B permiten a los equipos de marketing conocer mejor las preferencias de los clientes, optimizar las campañas y obtener un mayor ROI del tráfico existente. Finalmente, incluso los cambios más pequeños pueden dar lugar a mejoras significativas.

Equipos de producto

Disminuir la tasa de rebote

Una de las métricas más importantes para evaluar el rendimiento de tu sitio web es la tasa de rebote. Por ejemplo, puede haber muchas razones para una tasa de rebote alta, como demasiadas opciones para elegir, expectativas no cumplidas, navegación confusa, etc. En lugar de adivinar dónde está el problema, los equipos de producto pueden identificarlo y hacer cambios en el diseño, el contenido o la funcionalidad para que atraigan mejor a los usuarios y mantenerlos más tiempo en la página.

Introducir cambios con el mínimo riesgo

Antes de introducir nuevas funciones de producto, puedes hacer tests A/B para saber si realmente encajan con el público de tu sitio web.

Implementar un cambio en tu página web sin probarlo puede ser contraproducente tanto a corto como a largo plazo. Por lo tanto, probando y luego introduciendo cambios, puedes predecir el resultado con mayor certeza.

Equipos de crecimiento

Conseguir resultados estadísticamente significativos

Los equipos de crecimiento pueden justificar las decisiones estratégicas ante las partes interesadas utilizando los informes de los tests A/B. Debido a que los tests A/B se basan totalmente en datos, no dejan lugar a conjeturas, intuiciones o instintos. De esta manera, puedes identificar rápidamente un «ganador» y un «perdedor» basándote en mejoras estadísticamente significativas.

Rediseñar páginas webs enteras para asegurar futuras ganancias

Además de ayudar a ajustar un pequeño texto o color del CTA, los tests A/B permiten rediseñar completamente el sitio web. Los equipos de crecimiento pueden mejorar el diseño de un sitio web sin riesgos probando nuevas ideas de forma incremental y midiendo su impacto. En resumen, este enfoque garantiza que los cambios se basan en datos y que las mejoras se alinean con los objetivos empresariales.

4. ¿Qué aspectos se pueden testear en una prueba A/B?

En general, puedes (y deberías) probar prácticamente cualquier elemento de tu sitio web, tanto del front-end como del back-end. A continuación, te presentamos algunos casos clave de uso de funciones del lado del cliente y del lado del servidor que pueden probarse con un test A/B:

Client-Side (lo que ve el cliente)

Los tests A/B del lado del cliente o front-end prueban cambios en elementos visuales que los usuarios ven y con los que interactúan en su navegador. Es ideal para probar cambios de UI/UX y contenidos porque no requieran cambios en el backend y por lo tanto los pueden realizar equipos no técnicos (por ejemplo, marketing) utilizando un editor visual. Aquí tienes algunos elementos que puedes probar:

- Textos

- Diseño y estructura

- navegación

- formularios

- CTA (llamada a la acción)

- Prueba social

- Profundidad de desplazamiento

Server-Side (lo que ocurre en el servidor)

Sin embargo, los tests A/B del lado del servidor se refieren a cambios en la lógica o la infraestructura del backend, como probar nuevos algoritmos, introducir funciones o personalización. Es ideal para experimentos que requieren procesamiento de datos, entrega de contenidos dinámicos o ejecución fluida en distintos dispositivos. Aquí tienes algunos ejemplos de funciones que pueden probarse en el lado del servidor:

- Recomendaciones de productos

- Precios

- Lógica de clasificación

- Algoritmos de búsqueda

- Flujos de pago

- Personalización compleja

5. Ejemplos de A/B Testing

Ahora que sabemos lo que podemos probar, veamos cómo sería en la práctica. ¿Prefieres ver un ejemplo en tu propia página web? Solicita una demostración en directo aquí.

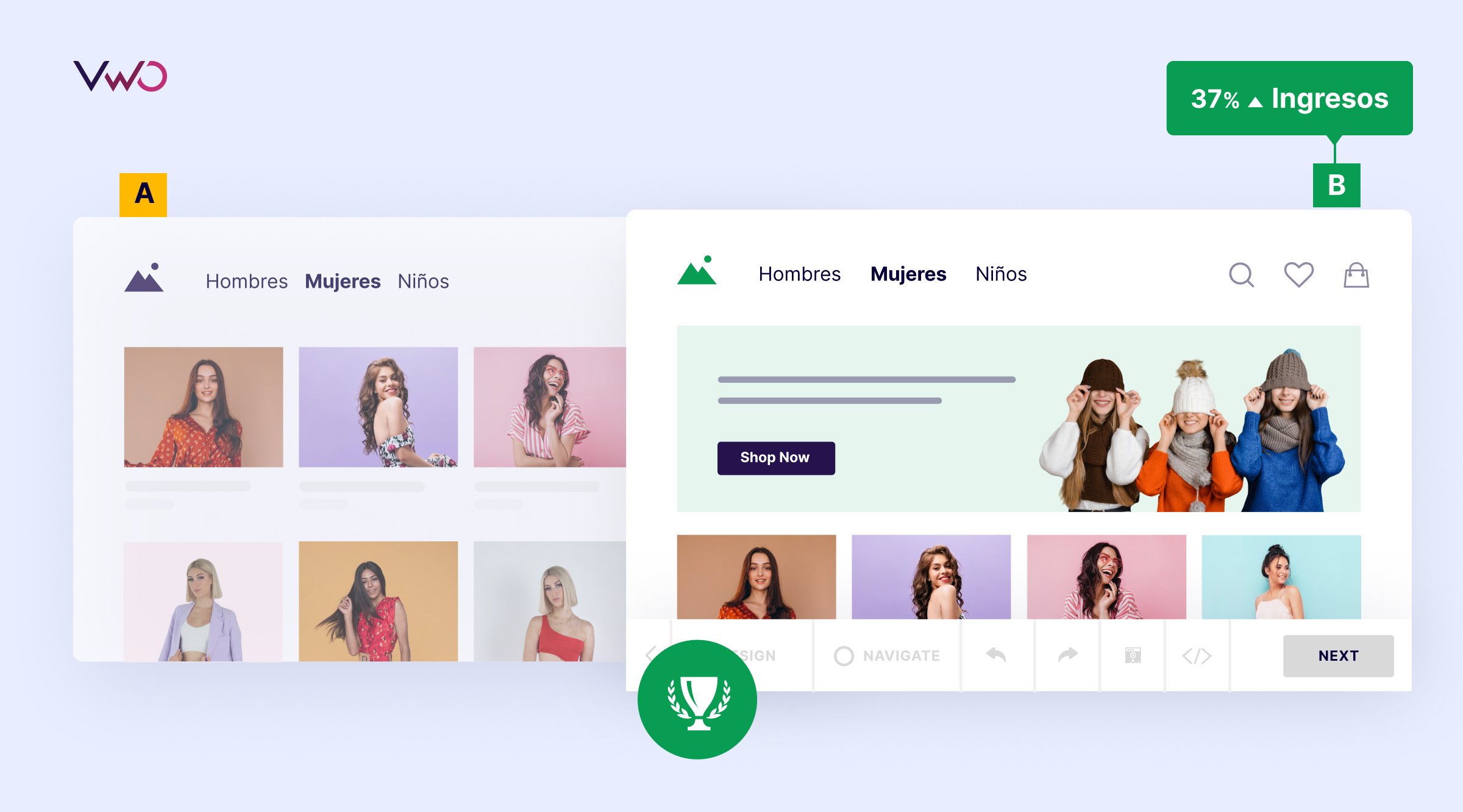

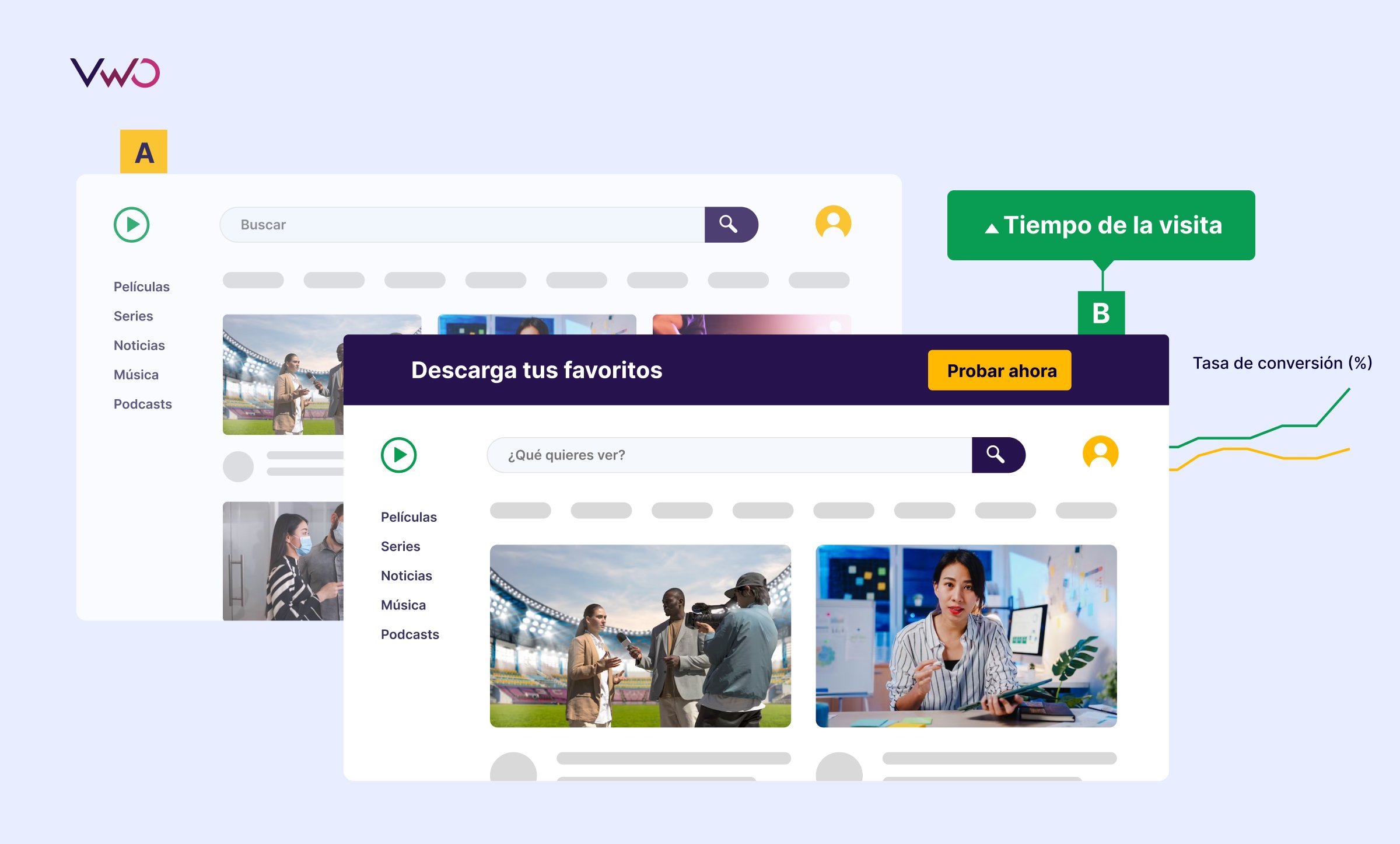

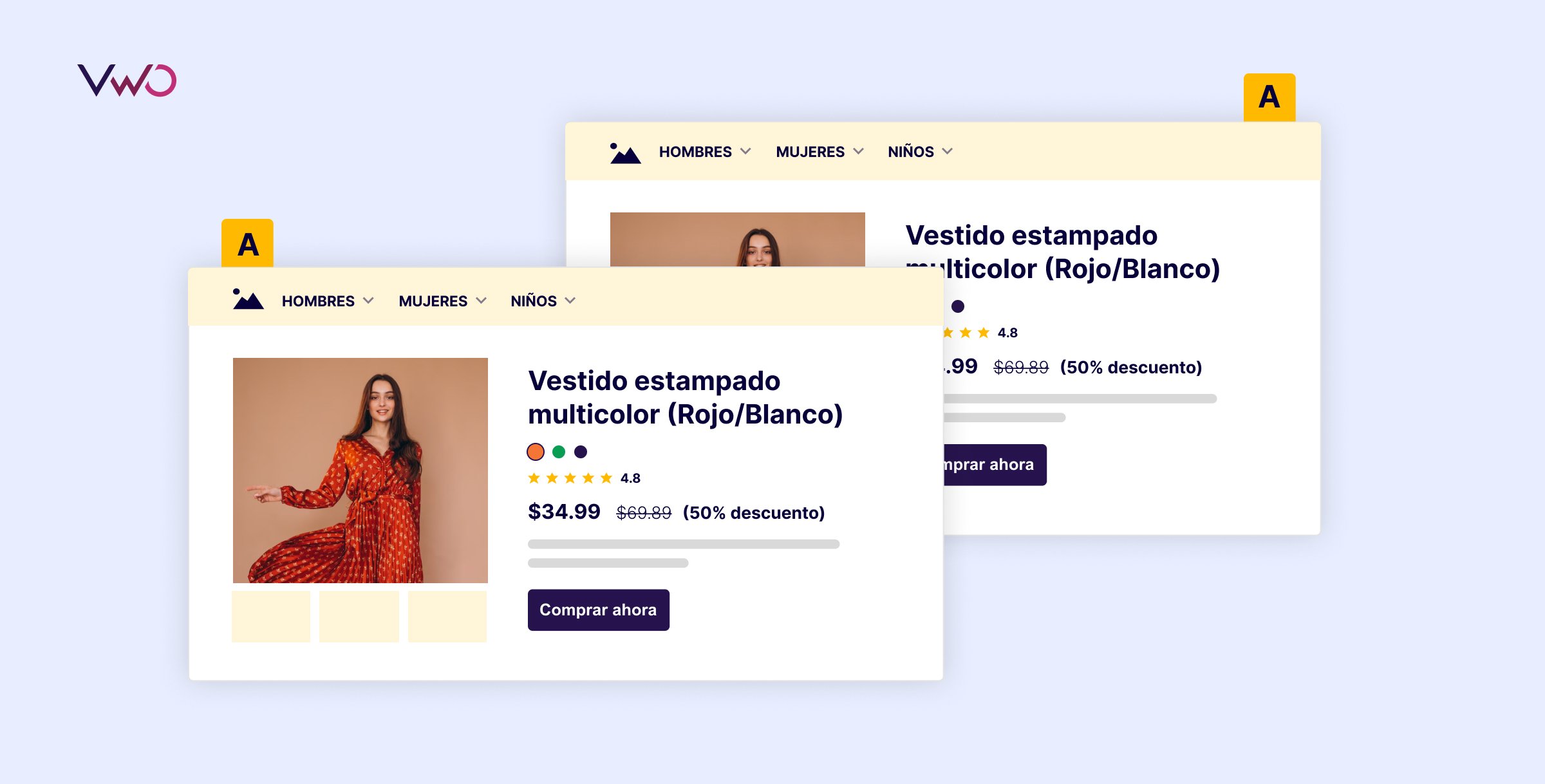

Ejemplo de un Test A/B Client-Side: Mejorar el tiempo de la visita de una plataforma de streaming

En este test A/B, se hicieron dos cambios clave en la variante (versión B). Primero, se añadió un banner en la parte superior invitando a los visitantes a registrarse para una prueba gratuita y recordándoles que el contenido se puede descargar para verlo offline. Después, se cambió el texto del cuadro de búsqueda de «Buscar» a «¿Qué quieres ver?» para crear una experiencia más personalizada. Estos ajustes aumentaron el tiempo de permanencia en un 37%, convirtiendo a la versión B en la clara ganadora.

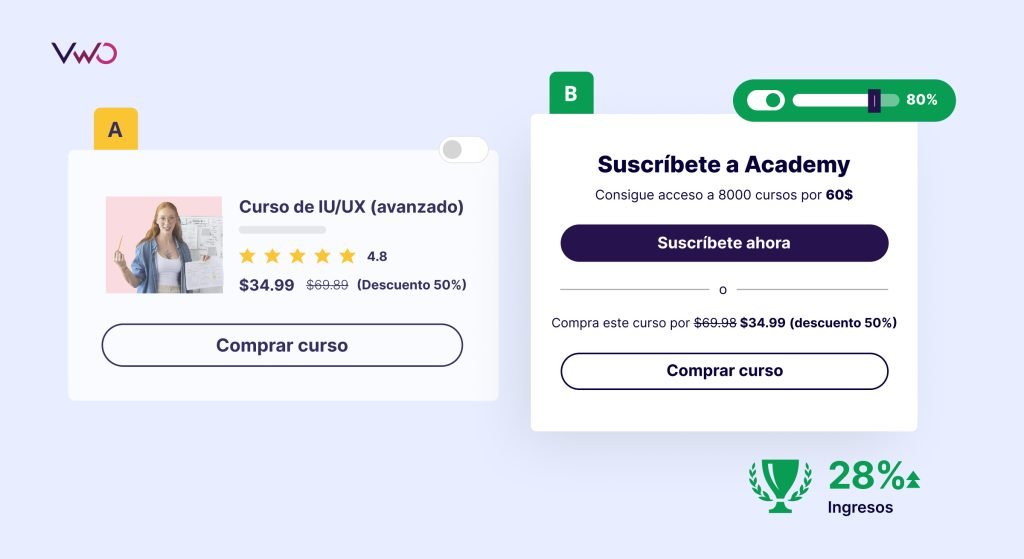

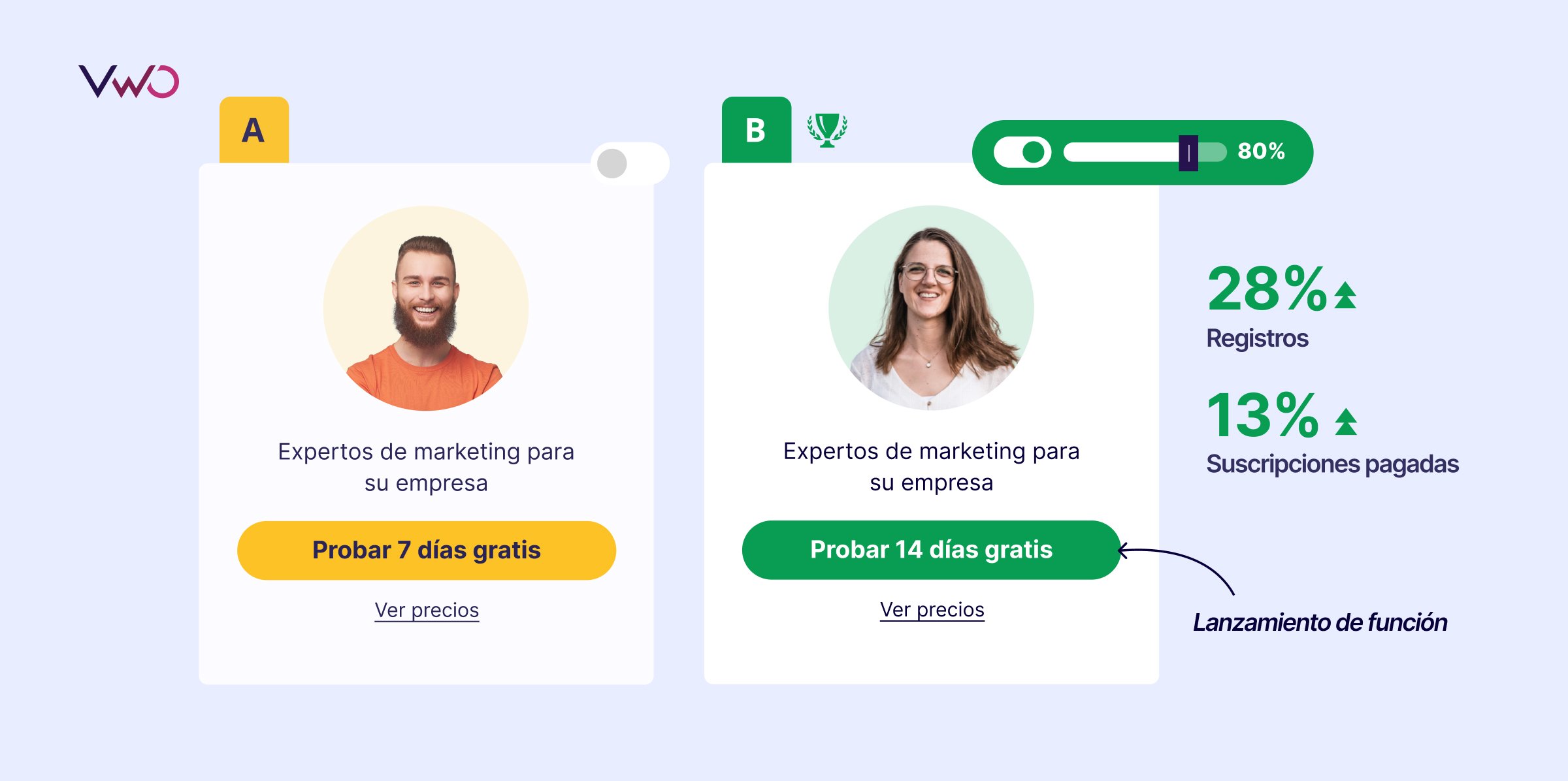

Ejemplo de test A/B server-side: Comparar un descuento con una suscripción

En este ejemplo de test A/B del lado del servidor, exploramos qué ocurre cuando introducimos una opción de suscripción además de la oferta existente del 50% de descuento. El objetivo es determinar si la opción adicional genera más participación y ventas. Los resultados son claros: la variante con la opción de suscripción provoca un aumento significativo de las ventas del 28%.

Para ver ejemplos concretos de tests que han realizado nuestros clientes puedes consultar sus historias de éxito aquí.

6. Tipos de pruebas A/B

Existen diferentes tipos o variaciones de tests A/B. Estos son los más frecuentes:

Split Test

Mucha gente utiliza los términos “test A/B” y “split test” de forma similar. Sin embargo, tienen sus diferencias. Los Split-URL-tests se refieren a un proceso experimental en el que se prueba una versión completamente nueva de la URL de un sitio web existente para analizar qué versión funciona mejor.

Las pruebas A/B, en cambio, comparan distintos elementos de un sitio web sin crear una URL completamente nueva. Los split tests suelen utilizarse para cambios más complejos, como el rediseño completo de una marca.

Tests Multivariante

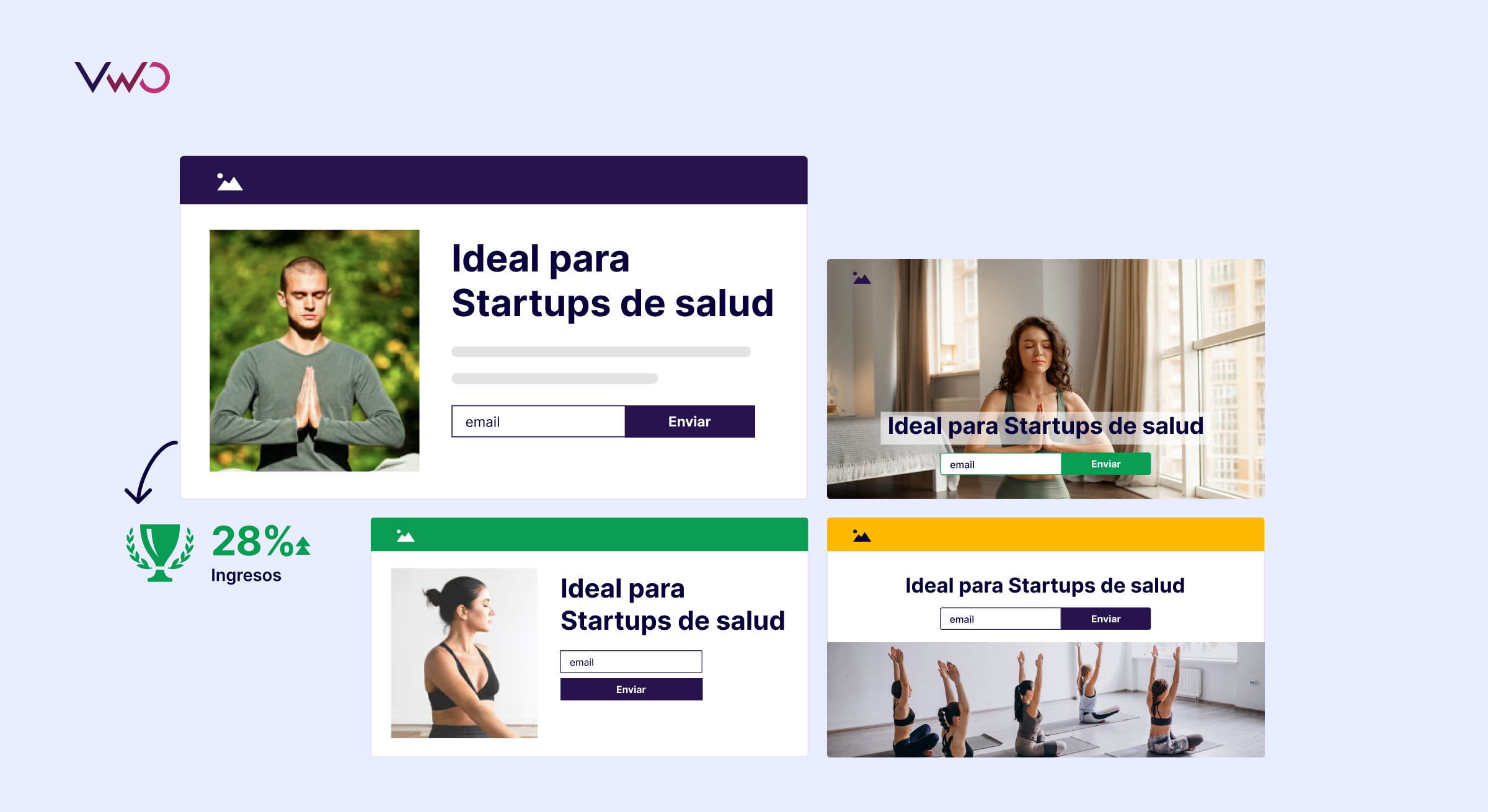

Los tests multivariantes (MVT ) son tests en los que se prueban simultáneamente variaciones de múltiples elementos para analizar qué combinación de elementos funciona mejor.

Supongamos que quieres probar dos versiones de una imagen, el color de un botón de llamada a la acción y los titulares de una de tus páginas de destino. Una prueba multivariable creará automáticamente 8 versiones de la página con todas las combinaciones posibles de cambios para determinar cuál mejora la métrica que estás siguiendo. No tienes que configurar tú mismo las ocho páginas.

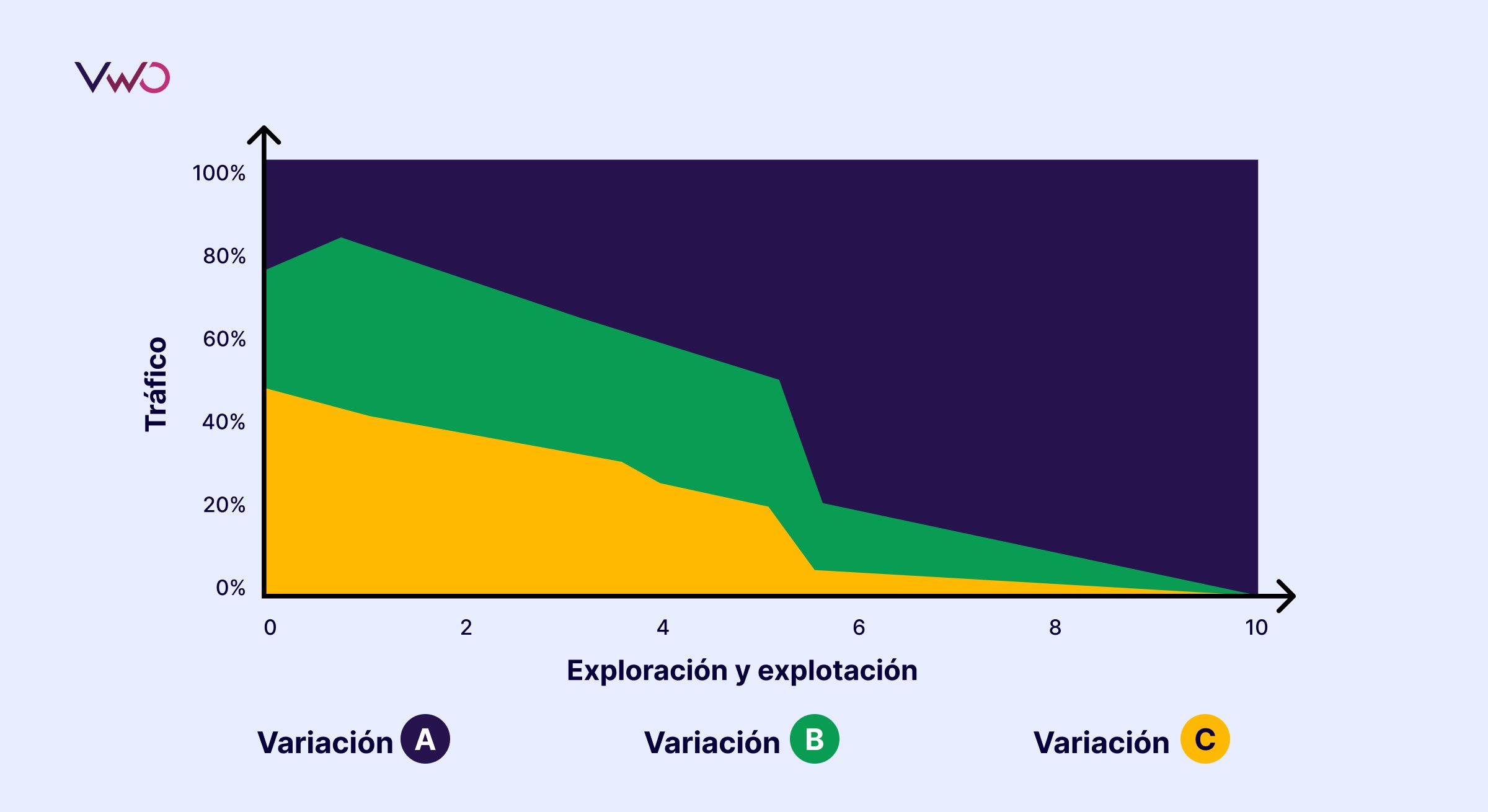

Test Multi-Armed-Bandit

En comparación con un test A/B convencional, un test Multi-Armed-Bandit no requiere esperar a que finalice el experimento para dirigir el tráfico a la versión ganadora. En este caso, el tráfico se asigna de forma dinámica y creciente a la versión que tiene más conversiones.

Tests A/A

En un test A/A, se compara un elemento de dos páginas idénticas. En lugar de determinar un aumento de las conversiones, el objetivo de un test A/A es verificar que no hay diferencia entre tu versión de control y tu versión de variación. «¿Qué sentido tiene?», te estarás preguntando. Los test A/A se utilizan a menudo para evaluar la herramienta de A/B Testing utilizada o para identificar errores que podrían afectar a los resultados de los test A/B.

Tests de funciones

Los tests de funciones se realizan cuando se introduce una nueva función en una aplicación o se modifica una función existente. También pueden definirse como un proceso en el que se prueban múltiples iteraciones de la función para determinar la versión más satisfactoria de la función que proporcione la mejor experiencia al usuario.

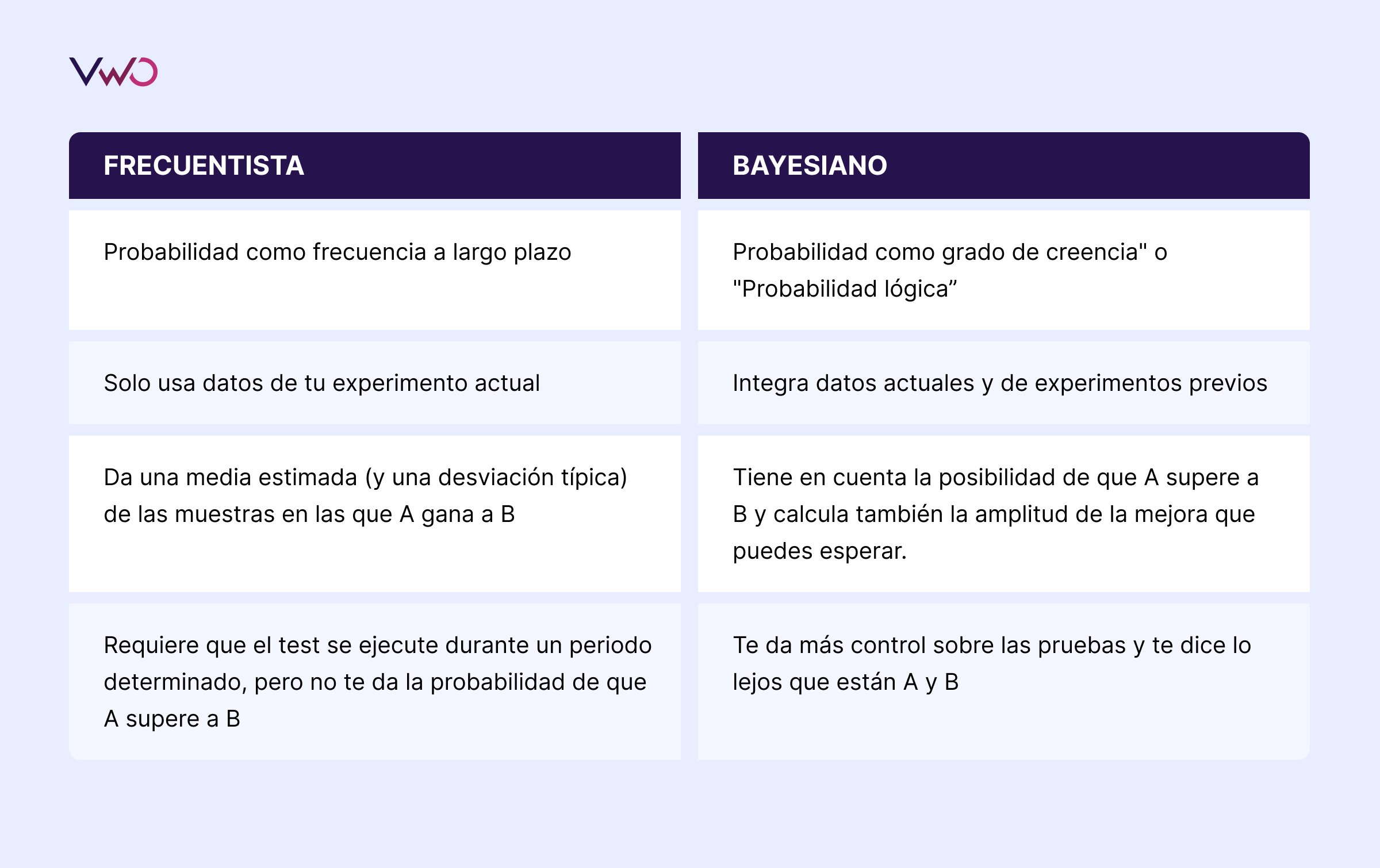

7. ¿Qué enfoque estadístico se utiliza en un test A/B?

Es importante saber qué enfoque estadístico elegir para realizar con éxito un test A/B y sacar las conclusiones correctas.

En general, se utilizan dos enfoques estadísticos para los tests A/B: Frecuentista y Bayesiano. Ambos enfoques tienen sus propias ventajas e inconvenientes. En VWO, utilizamos y recomendamos el enfoque bayesiano.

La siguiente comparación entre ambos enfoques te ayudará a entender por qué.

8. ¿Cómo es el proceso de A/B Testing?

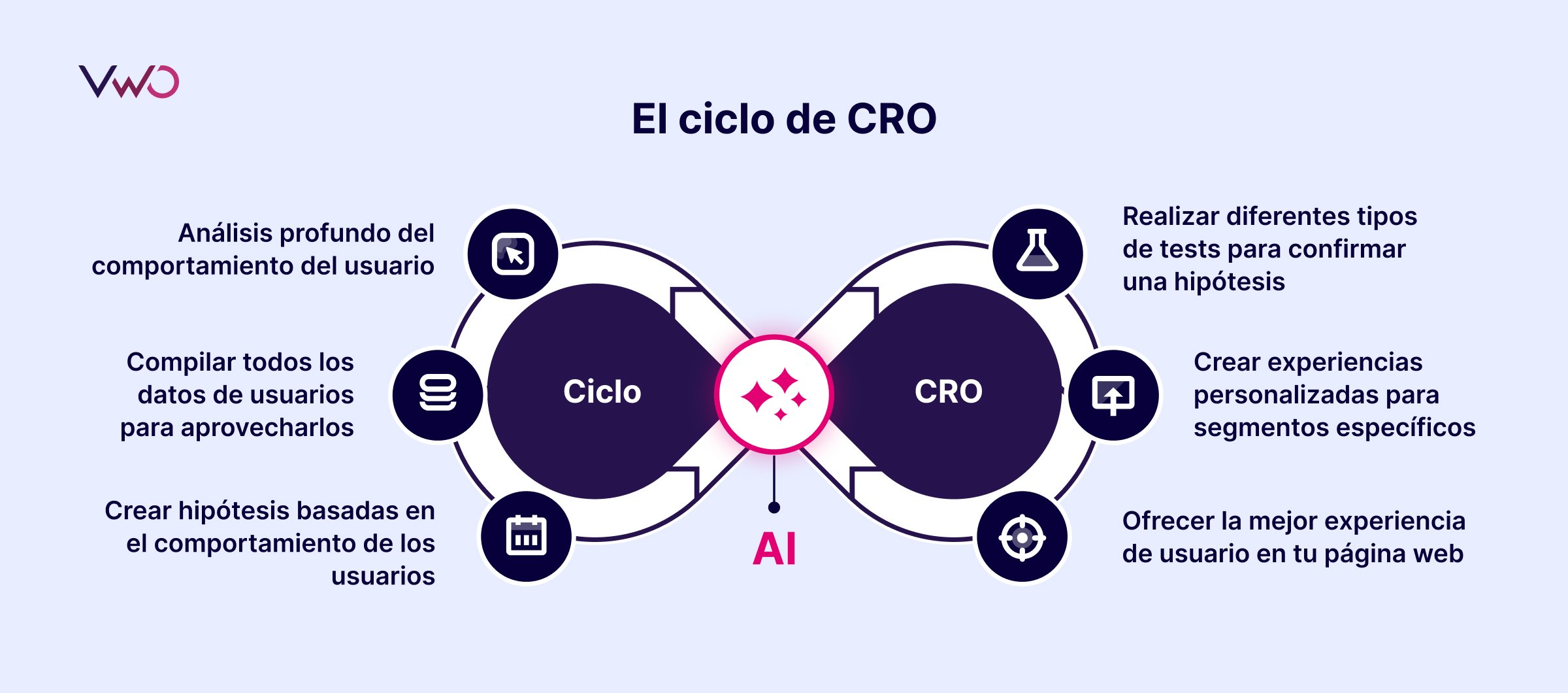

El A/B Testing nunca deben verse como un ejercicio aislado de optimización. Forma parte de un ciclo de CRO más amplio y holístico, y debe tratarse como tal. Un proceso de A/B Testing o ciclo de CRO eficaz suele constar de 6 partes.

Para ver otra versión de un ciclo de A/B Testing, echa un vistazo a este clip de nuestro webinar con Juanma Varo de Product Hackers y nuestro director de VWO para Europa, Jan Marks. Puedes encontrar el webinar completo aquí.

1. Análisis profundo del comportamiento del usuario

Esta es la fase de planificación de tu programa de A/B Testing. Se trata de medir el rendimiento de tu página web y cómo responden los visitantes a ella. En esta fase, debes ser capaz de averiguar qué ocurre en tu página web, por qué ocurre y cómo responden los visitantes. Herramientas como los heatmaps, las grabaciones de sesiones y las encuestas son esenciales.

2. Compilar todos los datos de usuarios para poder aprovecharlos

Una vez recopilados los datos, es hora de registrar las observaciones y empezar a planificar tu campaña. Mejores datos significan mayores ventas.

Cuando se hayan definido los objetivos empresariales, fijado los KPI y analizado los datos del sitio web y el comportamiento de los visitantes, es hora de crear un backlog. Tu backlog debe ser una lista exhaustiva de todos los elementos del sitio web que quieres probar basándote en los datos analizados.

3. Crear hipótesis

Ahora puedes empezar a crear hipótesis basadas en datos. Por ejemplo, supongamos que analizas los datos recogidos en la primera fase utilizando herramientas de investigación cuantitativa y cualitativa y llegas a la conclusión de que la falta de opciones de pago hace que la mayoría de los clientes potenciales abandonen el proceso de compra en la página de pago. Así que planteas la hipótesis de que “añadir múltiples opciones de pago ayudará a reducir la tasa de abandono en la página de pago”.

Para priorizar tus hipótesis, puedes utilizar el marco CIE (del inglés confidence, importance y ease). En este marco, hay tres parámetros por los que tienes que calificar tu prueba en una escala de 1 a 5:

Confianza: ¿Hasta qué punto confías en que conseguirás la mejora esperada de la hipótesis?

Importancia: ¿Cómo de importante es el test (para el que se crea la hipótesis)?

Facilidad: ¿Cómo de difícil será aplicar los cambios identificados para el test?

Si te faltan ideas durante esta fase, no te preocupes. Ahora con VWO puedes obtener ideas de tests generadas por IA.

4. Realizar diferentes tipos de tests para confirmar una hipótesis

La cuarta fase, y la más importante, es la fase del test. Ahora tienes todos los datos necesarios y un backlog priorizado. Una vez que hayas formulado hipótesis que se ajusten a tu objetivo y las hayas priorizado, crea variaciones y comienza a realizar tests. Durante la fase de testing, asegúrate de que se cumplen todos los requisitos para obtener resultados estadísticamente significativos antes de la finalización, por ejemplo, tener el tráfico adecuado, no probar demasiados elementos juntos, hacer el test con la duración adecuada, etc.

5. Crear experiencias personalizadas para segmentos específicos

Al analizar los resultados de los tests, es importante observar el comportamiento de los distintos segmentos de usuarios. Puede que una variante haya perdido en general, pero para los usuarios conectados desde un smartphone, el cambio haya sido un éxito. Es una oportunidad para personalizar la experiencia para este grupo de usuarios.

6. Ofrecer la mejor experiencia de usuario en tu página web

El análisis de los resultados es extremadamente importante. Como los tests A/B requieren una recogida y análisis continuos de datos, este paso implica analizar toda tu campaña. Una vez finalizado el test, analiza los resultados teniendo en cuenta métricas como el porcentaje de aumento, el nivel de confianza, el impacto directo e indirecto en otras métricas, etc. Si la prueba tiene éxito, despliega la variante ganadora teniendo en cuenta estas cifras. Si la prueba no es decisiva, saca conclusiones de ella y aplícalas en tus siguientes tests.

9. Errores comunes en el A/B Testing

Los tests A/B son una de las formas más eficaces de impulsar las métricas empresariales y aumentar los ingresos. Sin embargo, como ya hemos visto, los tests A/B requieren planificación, paciencia y precisión. Los pequeños errores pueden hacer perder tiempo y dinero. Para evitarlo, aquí tienes una lista de los errores más comunes que pueden producirse al realizar una test A/B:

Error 1: No tener un roadmap de Testing

Un roadmap de testing eficaz empieza con hipótesis sólidas. Todos los pasos posteriores dependen de ellas: Qué hay que modificar, por qué hay que modificarlo, cuál es el resultado esperado, etc. Si se empieza con una hipótesis equivocada, la probabilidad de que el test tenga éxito disminuye.

A menudo tenemos la tentación de limitarnos a probar algo que le funcionó a otra persona. Seguro que otra persona cambió su procedimiento de registro y vio un aumento del 30% en las conversiones, pero es el resultado de su test, a causa de su tráfico, su hipótesis y sus objetivos. No hay dos páginas web iguales: lo que ha funcionado para otros no necesariamente funcionará para ti a causa de que el tráfico es diferente, el público objetivo puede ser distinto, el método de optimización puede haber sido diferente al tuyo, etc.

Error 2: Duración incorrecta de los tests

Dependiendo del tráfico y del objetivo, deberás ejecutar tus tests A/B durante un tiempo determinado para alcanzar significancia estadística. Un test demasiado largo o demasiado corto puede hacer que fracase o produzca resultados insignificantes. Si una versión de tu página web parece ganar en los primeros días tras el inicio del test, esto no significa que debas detener el test antes de tiempo. Ejecutar una campaña durante demasiado tiempo también es un error común. La duración del test depende de varios factores, como el tráfico existente, la tasa de conversión existente, la mejora esperada, etc.

Averigua aquí cuánto tiempo debe durar tu test.

Error 3: Utilizar la herramienta equivocada

A medida que los tests A/B se han ido popularizando, han aparecido en el mercado varias herramientas de diferentes costes. No todas estas herramientas son igual de buenas. Algunas herramientas ralentizan drásticamente tu página web, mientras que otras no disponen de funciones necesarias (heatmaps, grabaciones de sesiones, etc.) para garantizar los resultados de tus tests.

Error 4: Ignorar factores externos

Para obtener resultados significativos, los tests deben realizarse en periodos comparables. Por ejemplo, las tiendas online conocen la diferencia entre el tráfico en primavera (normal) y el periodo prenavideño (muy alto). Un mismo test conduciría a resultados diferentes y probablemente falsos según el periodo debido al factor externo de la Navidad. Utiliza la calculadora de significancia de tests A/B de VWO para averiguar si los resultados de tu test son significativos o no.

Error 5: No seguir un proceso iterativo

El A/B Testing es un proceso iterativo en el que cada experimento se basa en los resultados del anterior. Muchas organizaciones abandonan los tests A/B si el primero no gana. Sin embargo, para aumentar las posibilidades de éxito del siguiente test, debes utilizar los resultados de los tests anteriores al planificarlo y realizarlo. Esto aumenta la probabilidad de que tu test ofrezca resultados estadísticamente significativos.

Además, no deberías detenerte cuando una campaña de tests haya tenido éxito. Prueba cada elemento varias veces para conseguir versiones cada vez mejores.

10. A/B Testing y SEO

Google ha aclarado el impacto del SEO en los tests A/B en el artículo de su blog titulado «Website Testing And Google Search». Aquí resumimos los puntos más importantes de este artículo:

Prohibido el cloaking

El cloaking (mostrar un conjunto de contenidos a los humanos y otro al Googlebot) va en contra de nuestras directrices, tanto si realizas un test como si no. Asegúrate de no utilizar el agente de usuario para decidir si realizar el test o qué variante de contenido utilizar. Un ejemplo de esto sería proporcionar siempre el contenido original cuando veas el agente de usuario «Googlebot». Recuerda que infringir nuestras directrices puede hacer que tu página web baje de categoría o incluso sea eliminada de los resultados de búsqueda de Google, lo que probablemente no sea el resultado deseado de tu test.

Utiliza sólo redireccionamientos 302

Si estás realizando un test A/B en el que los usuarios son redirigidos desde la URL original a una URL de variación, utiliza una redirección 302 (temporal) y no una redirección 301 (permanente). Esto indica a los motores de búsqueda que esta redirección es sólo temporal -sólo existirá hasta que hayas completado el experimento- y que deben mantener la URL original en su índice en lugar de sustituirla por la página de prueba. Google también ha dado luz verde a las redirecciones basadas en JavaScript.

Realiza los experimentos durante el tiempo adecuado

El tiempo necesario para realizar un test fiable depende de varios factores, como tus tasas de conversión y el tráfico de tu página web. Una buena herramienta de testing debería indicarte cuándo has recopilado datos suficientes para sacar conclusiones fiables. Una vez que hayas completado el test, debes actualizar tu página web con las variantes deseadas y eliminar todos los elementos del test lo antes posible, por ejemplo, las URL alternativas o los scripts de prueba y el markup.

Utiliza enlaces rel=»canonical»

Google recomienda utilizar el atributo de enlace rel=«canonical« para todas las URL alternativas, de modo que puedas destacar que la URL original es la preferida. Esta sugerencia se basa en el hecho de que rel=»canonical» se ajusta mejor a tu intención en esta situación en comparación con otros métodos como la metaetiqueta “no index”. Por ejemplo, si estás probando variantes de tu página de producto, no quieres que los motores de búsqueda no indexen tu página de producto. Simplemente quieres que entiendan que todas las URL de prueba son duplicados cercanos o variantes de la URL original y deben agruparse, con la URL original en primer plano. En estos casos, utilizar «no index» en lugar de rel=»canonical» puede tener a veces efectos negativos inesperados.

11. Herramientas de A/B Testing

El mercado de herramientas de A/B Testing ha crecido mucho en los últimos años. Aquí tienes algunas de las herramientas más populares. Puedes encontrar nuestra comparación completa de todas sus funciones en esta entrada del blog.

1. VWO

2. Google Optimize (Ya no está disponible, pero migrar a VWO es cuestión de 30 segundos)

3. Optimizely

4. AB Tasty

5. Adobe Target

6. Dynamic Yield

7. Kameleoon

Conclusión: Pruébalo.

Si has llegado hasta aquí, ya deberías ser prácticamente un experto en tests A/B. Pero el A/B testing, como muchas otras disciplinas, es un arte que se perfecciona con la práctica. Puede que ya tengas algunas ideas que quieras probar, o puede que este artículo te haya inspirado para probar algo. En cualquier caso, nos encantaría mostrarte lo fácil que es poner en práctica tus ideas con VWO. Regístrate en nuestra versión de prueba gratuita o simplemente deja que te mostremos la plataforma en una demostración. ¿Necesitas más inspiración? Descárgate nuestro eBook «Qué esperan los usuarios de las tiendas online » y encuentra tu próxima idea de test A/B. ¡Ánimos!

Preguntas frecuentes sobre el A/B testing

El A/B testing es el proceso de comparación de dos versiones de un mismo elemento de una página web. Normalmente, esto se hace para comprobar cómo reaccionan los visitantes ante la variación A y la variación B y, de esta forma, decidir cuál de ellas resulta más efectiva.

En el sector del marketing digital, el A/B testing es el proceso mediante el cual se muestran dos versiones de una misma página web a distintos segmentos de visitantes al mismo tiempo para comparar cuál de ellas promueve más las conversiones.

Existen varios motivos por los que realizamos A/B testing, como solucionar puntos de fricción de cara a los visitantes, incrementar las conversiones y los leads, reducir la tasa de rebote, etc. Lee nuestra guía para conocer todas las razones al detalle.

En el A/B testing, el tráfico se divide en dos o más versiones completamente distintas de una página web. Los tests multivariante, por su parte, incluyen múltiples combinaciones de ciertos elementos clave de una página que se comparan entre sí para saber cuál de ellas funciona mejor de cara a alcanzar el objetivo marcado.