Follow us and stay on top of everything CRO

Read summarized version with

1. O que é teste A/B?

Definição de testes A/B

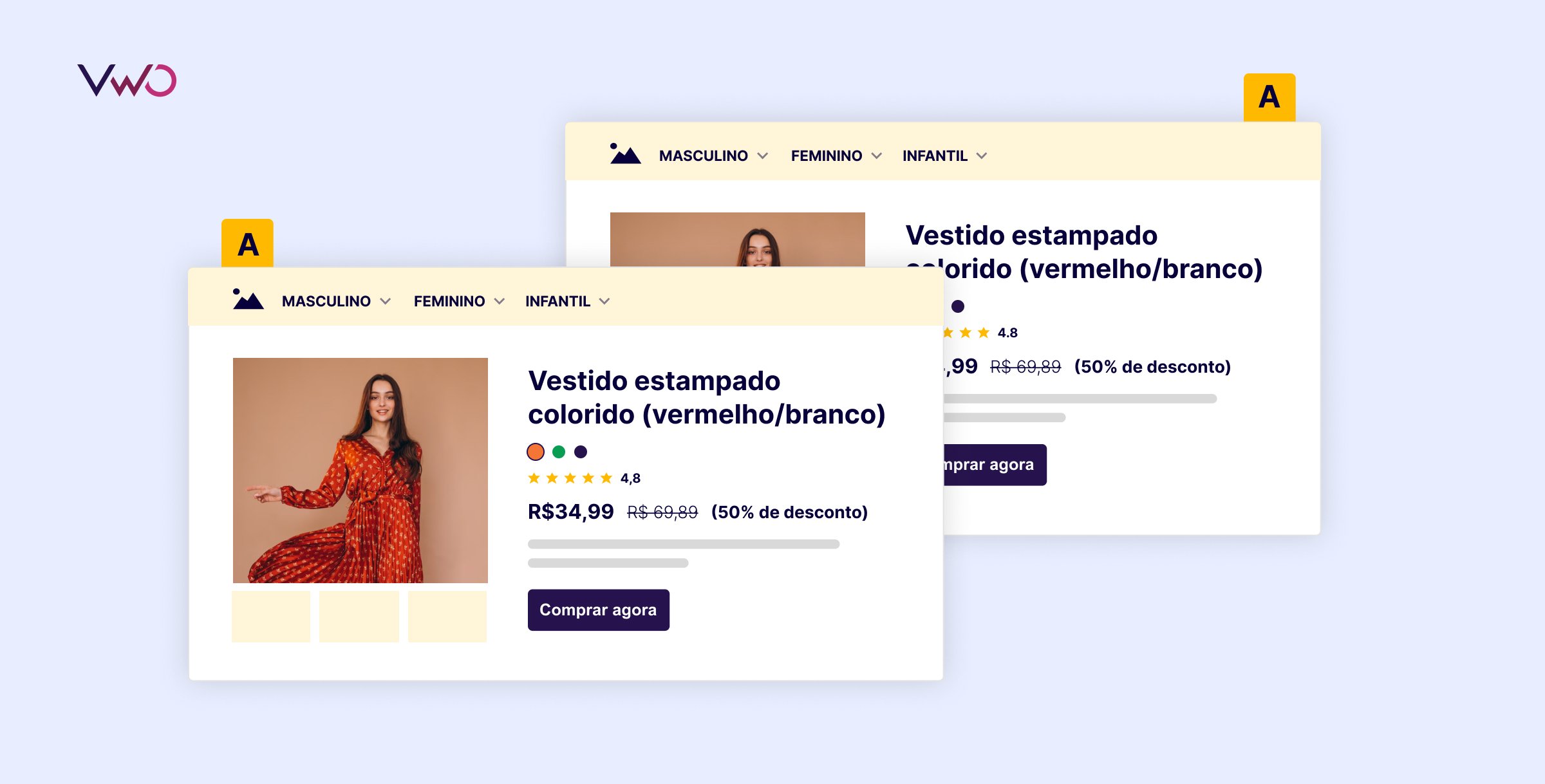

Os testes A/B, também conhecido como teste dividido, é um método em que se comparam duas ou mais variantes de uma página web, aplicativo ou elemento. O objetivo é determinar a variante mais eficaz para entender o que os usuários desejam e otimizar os objetivos comerciais (como, por exemplo, o número de conversões).

Os testes A/B evitam suposições no processo de otimização de um site, pois permitem tomar decisões baseadas em dados. A comparação de duas ou mais variáveis ajuda a responder a algumas dúvidas sobre métricas empresariais importantes. A versão que exerce um impacto positivo sobre essas métricas é considerada a vencedora do teste A/B.

Obviamente, o teste A/B faz parte do processo de otimização da taxa de conversão (CRO). Mas o significado dessas conversões pode variar entre as empresas. Por exemplo, para uma loja de comércio eletrônico, pode ser o número de vendas. Por sua vez, para uma empresa B2B, podem ser os leads captados.

Quer saber mais sobre o que os usuários esperam das lojas on-line e como você pode satisfazer as expectativas deles com testes A/B? Faça o download do nosso e-book gratuito: “O que os usuários esperam das lojas on-line”.

2. Como funciona um teste A/B?

Durante a realização de um teste A/B, metade dos visitantes do seu site acessa uma versão da página (A) e a outra metade visualiza a outra (B). Por exemplo, se o seu objetivo é convencer mais visitantes a se registrarem para fazer um teste gratuito, você pode inserir um botão de registro vermelho na versão A e um azul na versão B.

Além disso, também é possível experimentar diferentes posicionamentos para o botão no mesmo teste. Por exemplo:

- Versão A: botão vermelho na parte superior direita

- Versão B: botão vermelho na parte superior esquerda

- Versão C: botão azul na parte superior direita

- Versão D: botão azul na parte superior esquerda

A versão que apresentar o maior aumento no número de registros será a vencedora.

3. Quais são as vantagens do teste A/B para diferentes equipes?

Os testes A/B ajudam as empresas a tomar decisões baseadas em dados. Isso beneficia diferentes equipes de maneiras distintas. Vamos analisar três casos:

Equipes de Marketing

Resolver problemas dos usuários

Os visitantes acessam o seu site com um objetivo específico. É possível que eles queiram comprar um produto específico, aprender mais sobre um determinado assunto ou simplesmente conferir os preços. Seja qual for o objetivo, alguns problemas podem surgir no caminho. Talvez seja um texto confuso ou um botão de CTA, como “Comprar agora” ou “Solicitar uma demonstração”, difícil de encontrar.

Os testes A/B podem ajudar as equipes de marketing a identificar os problemas dos visitantes e testar diferentes soluções. Isso resulta na otimização da experiência do usuário e melhoria do desempenho do site, tomando como base o comportamento e os comentários de usuários reais.

Aumentar o ROI com o tráfego existente

Todo profissional de marketing sabe como o custo para obter tráfego de qualidade pode ser elevado. Por isso, os testes A/B permitem que as equipes de marketing conheçam melhor as preferências dos clientes, otimizem as campanhas e aumentem o ROI do tráfego já existente. Até mesmo as menores mudanças podem resultar em melhorias significativas.

Equipes de produto

Reduzir a taxa de rejeição

Uma das métricas mais importantes para avaliar o desempenho do seu site é a taxa de rejeição. Pode haver muitas razões pelas quais a sua taxa de rejeição é elevada, incluindo excesso de opções para o cliente escolher, expectativas que não são atingidas, navegação confusa, entre outras. Em vez de adivinhar onde está o problema, as equipes de produto podem identificá-lo e fazer alterações no design, conteúdo ou funcionalidade do site para atrair os usuários e mantê-los mais tempo engajados nas páginas.

Implementar mudanças com risco mínimo

Antes de implementar novas funcionalidades ao produto, a equipe pode realizar testes A/B para descobrir se elas realmente se adequam ao público de seu site.

Implementar uma mudança sem testá-la pode ter reflexos negativos tanto no curto quanto no longo prazo. Ao realizar testes e, depois, introduzir as mudanças, é possível prever qual será o resultado com maior nível de certeza.

Equipes de crescimento

Obter resultados estatisticamente significativos

As equipes de crescimento podem justificar as decisões estratégicas para as partes envolvidas usando os relatórios dos testes A/B. Como esse tipo de teste se baseia em dados, não há espaço para suposições, intuições ou adivinhações. Assim, é possível identificar rapidamente uma versão “vencedora” e uma “perdedora” a partir de melhorias com significância estatística.

Redesenhar páginas inteiras para garantir resultados futuros

Além de contribuírem com ajustes em um texto pequeno ou na cor do CTA, os testes A/B permitem reformular completamente um site. As equipes de crescimento podem melhorar o design das páginas sem correr riscos ao testar novas ideias de forma incremental e medir seu impacto. Essa abordagem garante que as mudanças adotadas sejam baseadas em dados e as melhorias estejam alinhadas aos objetivos da empresa.

4. Quais elementos podem ser testados em um teste A/B?

De modo geral, você pode (e deve) testar praticamente qualquer elemento do seu site, tanto no front-end quanto no back-end. Abaixo, apresentamos alguns casos de uso importantes de funções tanto no lado do cliente quanto no lado do servidor para testes A/B:

Lado do cliente (o que o cliente vê)

Nos testes A/B no lado do cliente (front-end), são feitos experimentos de alterações nos elementos que os usuários visualizam e com os quais eles interagem no navegador. Essa é uma opção ideal para testar mudanças na interface do usuário (UI), experiência do usuário (UX) e conteúdo, pois não requer mudanças no back-end. Portanto, o teste pode ser realizado por profissionais que não têm conhecimento técnico, como a equipe de marketing, por meio de um editor visual. Estes são alguns elementos que você pode testar:

- Textos

- Design e estrutura

- Navegação

- Formulários

- CTA

- Prova social

- Profundidade de deslocamento

Lado do servidor (o que acontece no servidor)

Já os testes A/B no lado do servidor são usados quando é preciso fazer alterações na lógica ou infraestrutura do back-end, como testar novos algoritmos, introduzir funções ou personalizar elementos. Essa é a opção ideal para realizar experiências que exigem processamento de dados, entrega de conteúdo dinâmico ou execução fluida em diferentes dispositivos. Estes são alguns exemplos de funções que podem ser testadas no lado do servidor:

- Recomendações de produtos

- Preços

- Lógica de classificação

- Algoritmos de busca

- Fluxos de pagamento

- Personalização complexa

5. Exemplos de testes A/B

Agora que você já sabe o que pode ser testado, vamos entender como o processo funciona na prática. Se quiser usar a sua própria página como exemplo, solicite uma demonstração aqui.

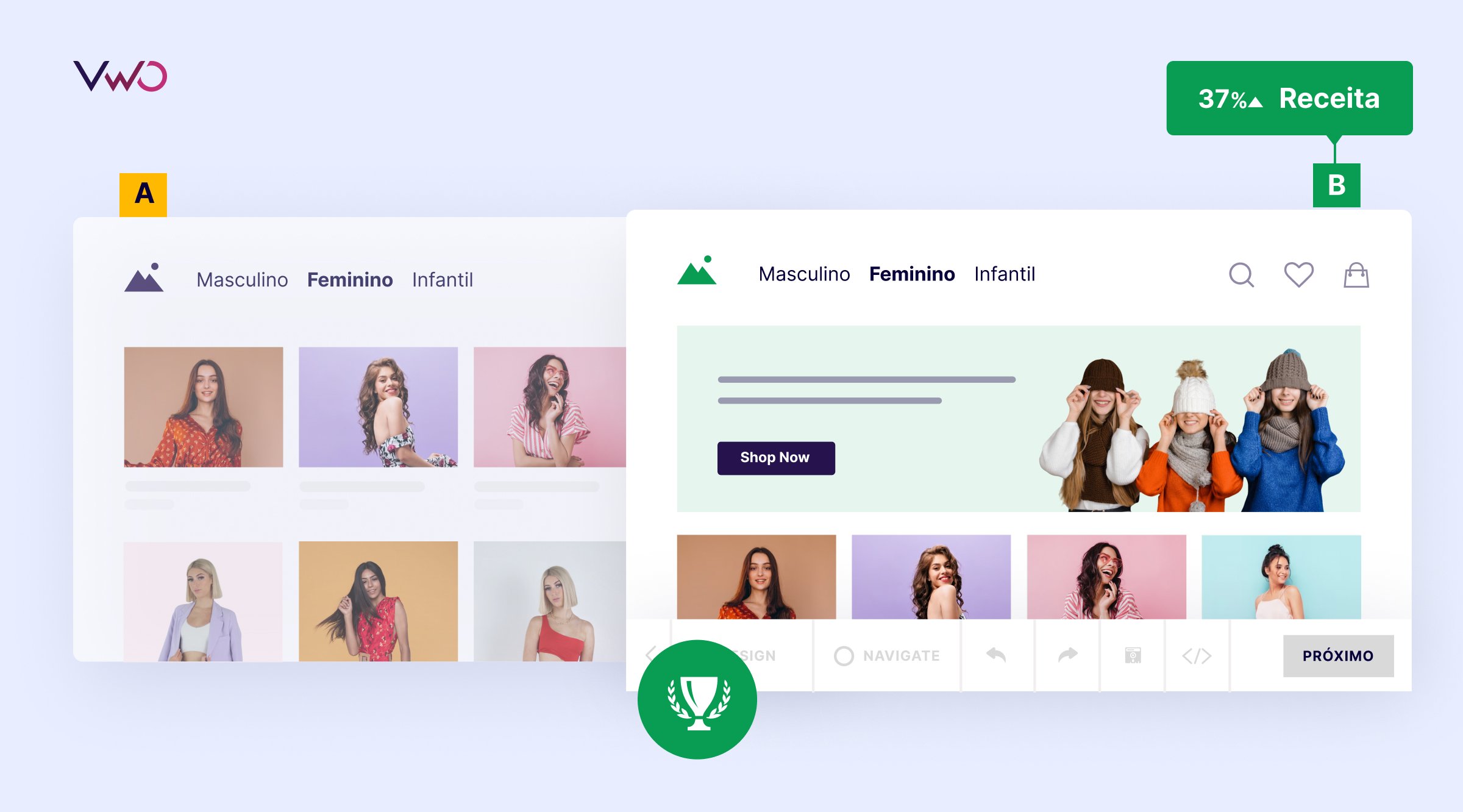

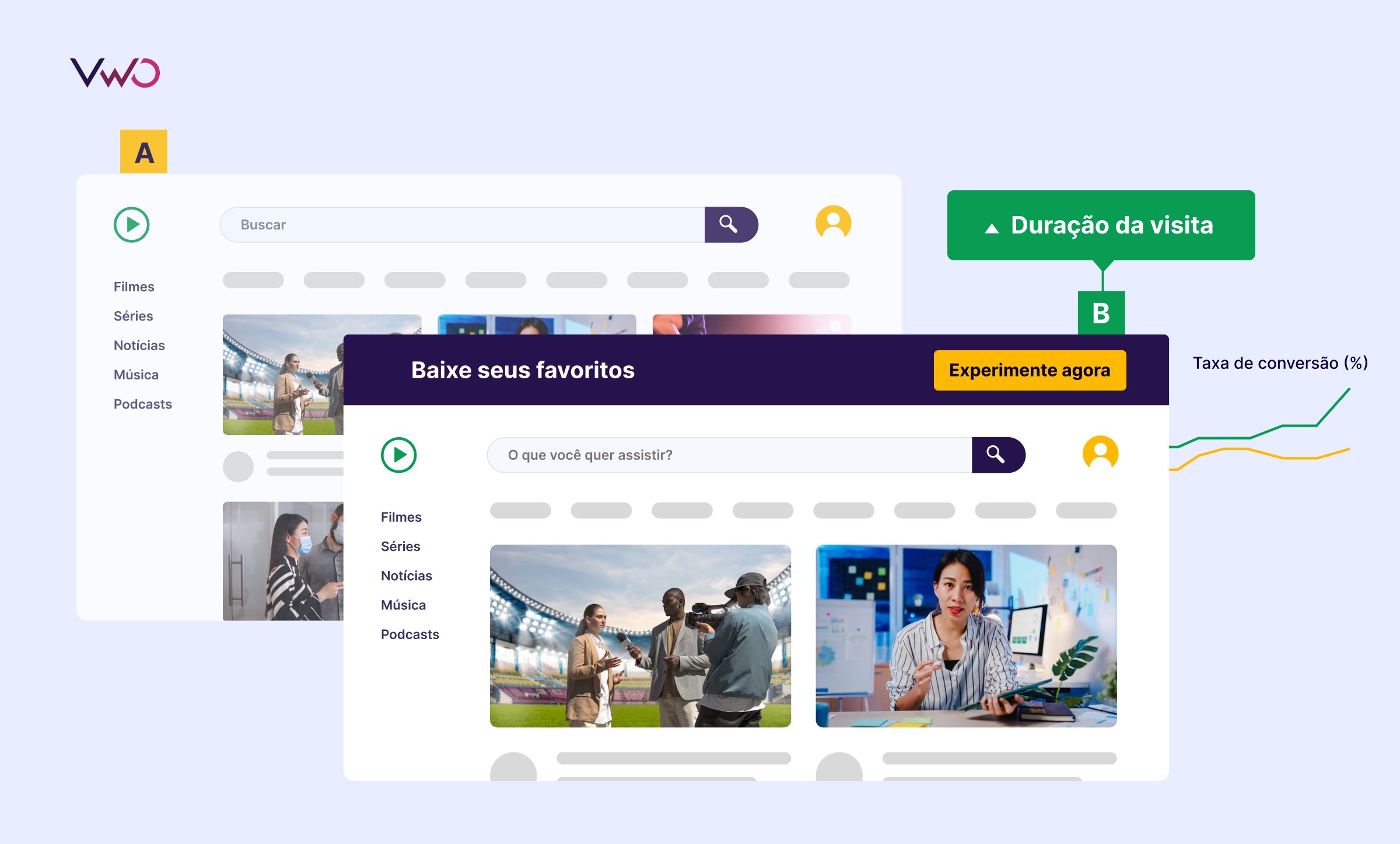

Exemplo de teste A/B no lado do cliente: aumentar o tempo de visita em uma plataforma de streaming

Neste teste A/B, foram feitas duas alterações importantes na variante (versão B). Primeiro, foi adicionado um banner na parte superior que convidava os visitantes a se cadastrarem para participar de um teste gratuito, destacando que o conteúdo podia ser baixado para ser assistido offline. Em seguida, o texto da caixa de pesquisa foi alterado de “Pesquisar” para “O que você deseja ver?”, criando uma experiência mais personalizada. Esses ajustes aumentaram o tempo de permanência dos visitantes em 37%, indicando que a versão B era a clara vencedora.

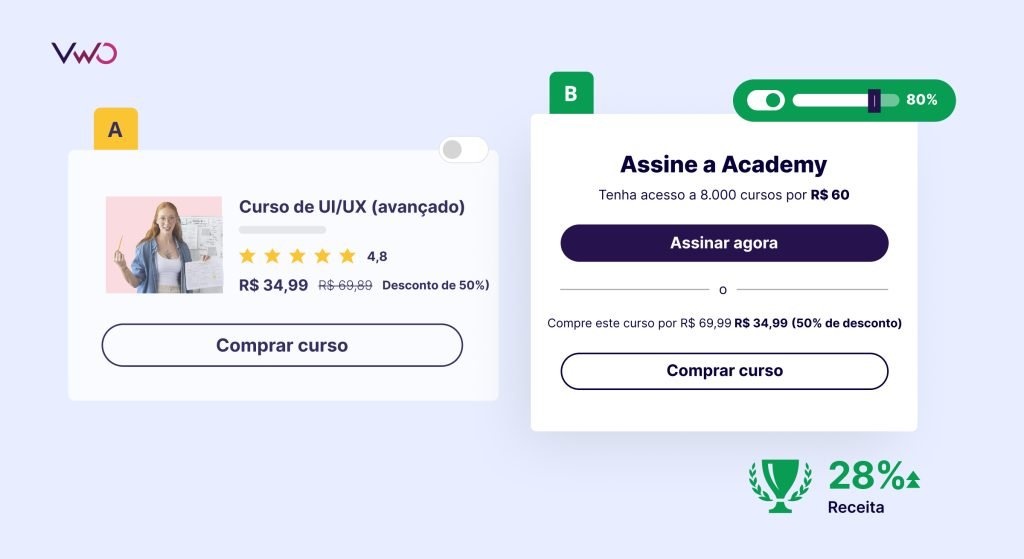

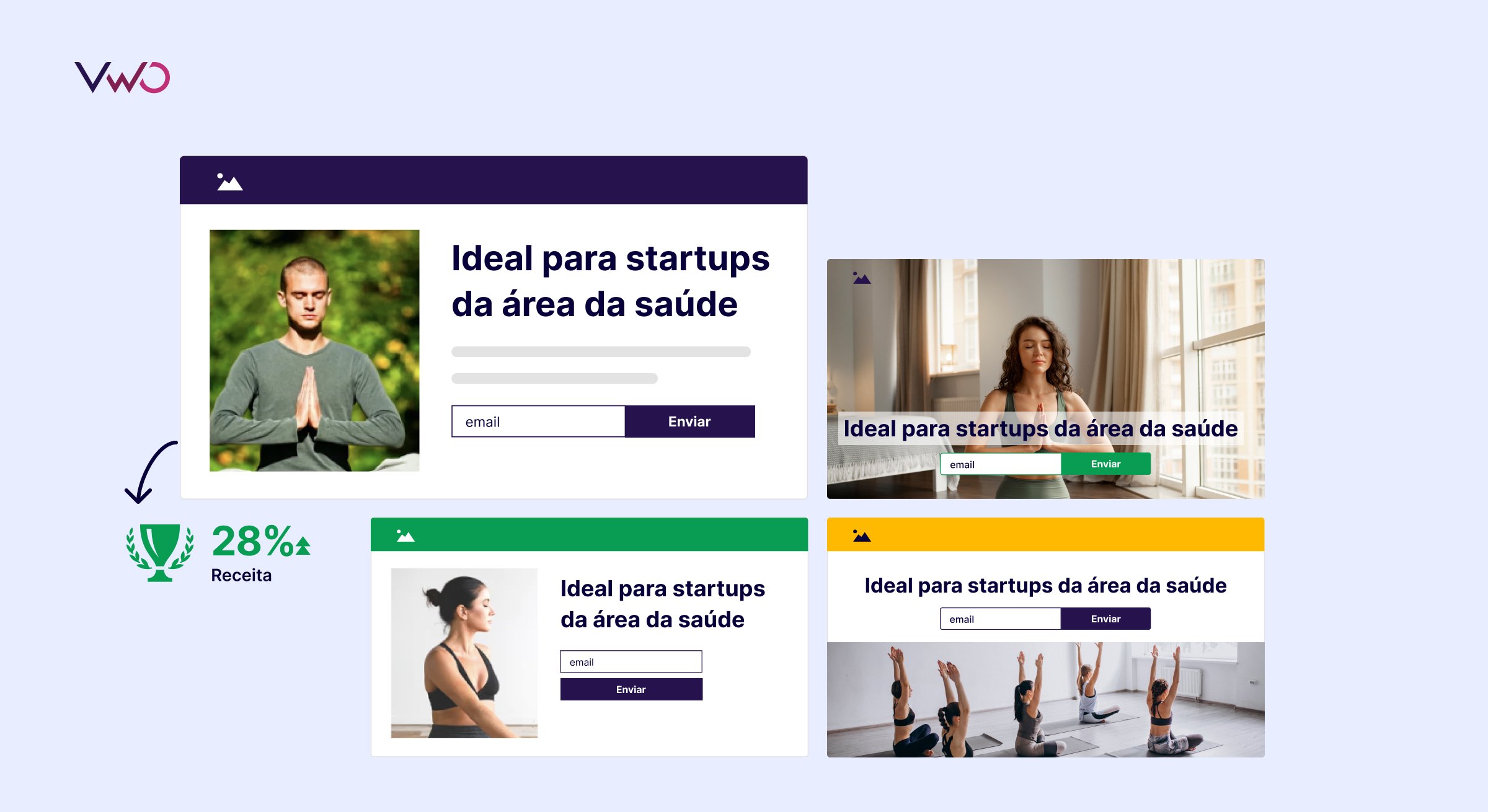

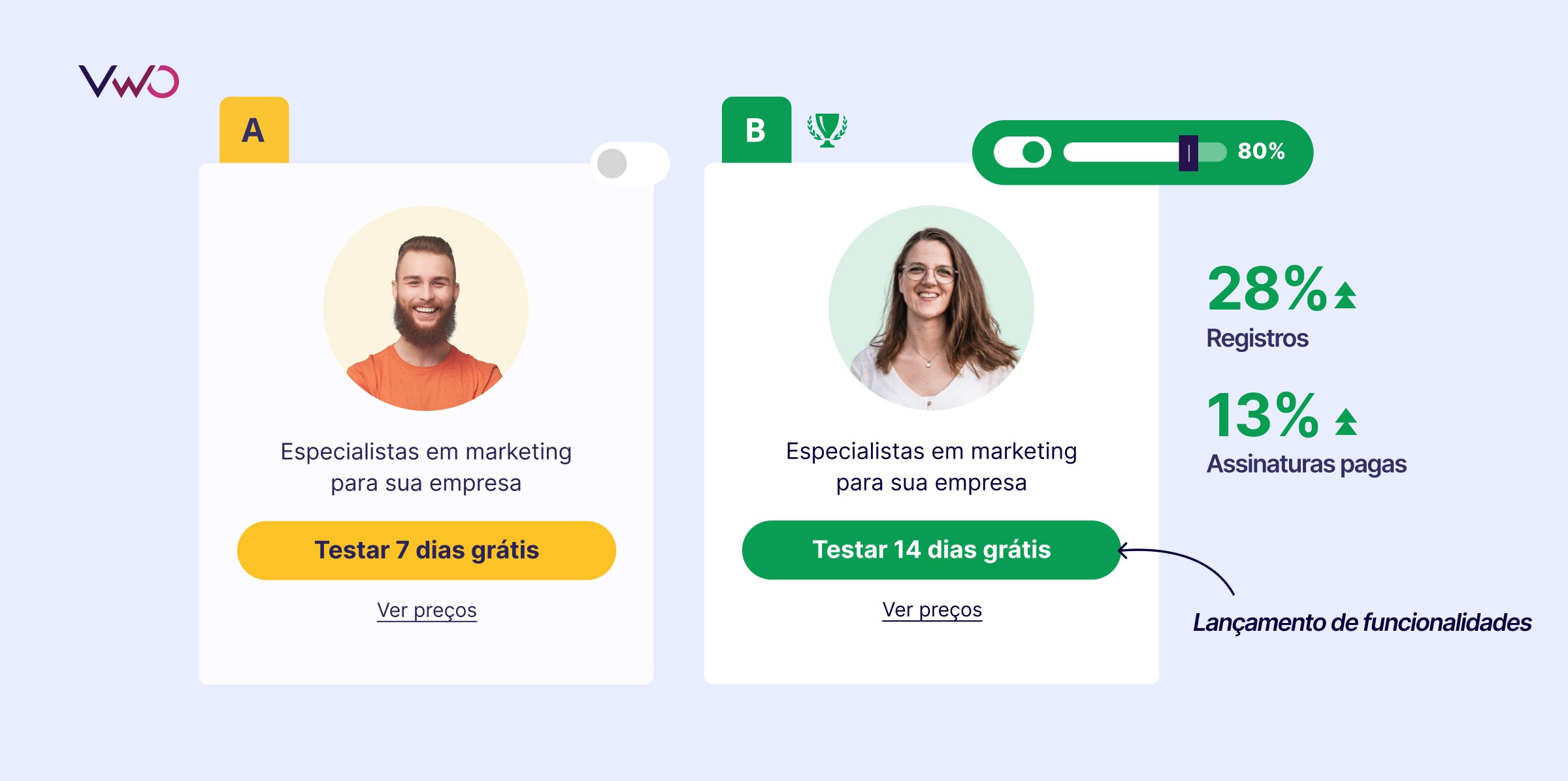

Exemplo de teste A/B no lado do servidor: comparar um desconto com uma assinatura

Neste exemplo de teste A/B no lado do servidor, exploramos o que aconteceria ao introduzir uma opção de assinatura além da oferta já existente de 50% de desconto. O objetivo era determinar se a opção adicional geraria mais participações e vendas. Os resultados foram claros: a variante com a opção de assinatura provocou um aumento significativo de 28% nas vendas.

Para conhecer exemplos concretos de testes realizados pelos nossos clientes, consulte as histórias de sucesso aqui.

6. Tipos de testes A/B

Existem diferentes tipos ou variações de testes A/B. Estes são os mais frequentes:

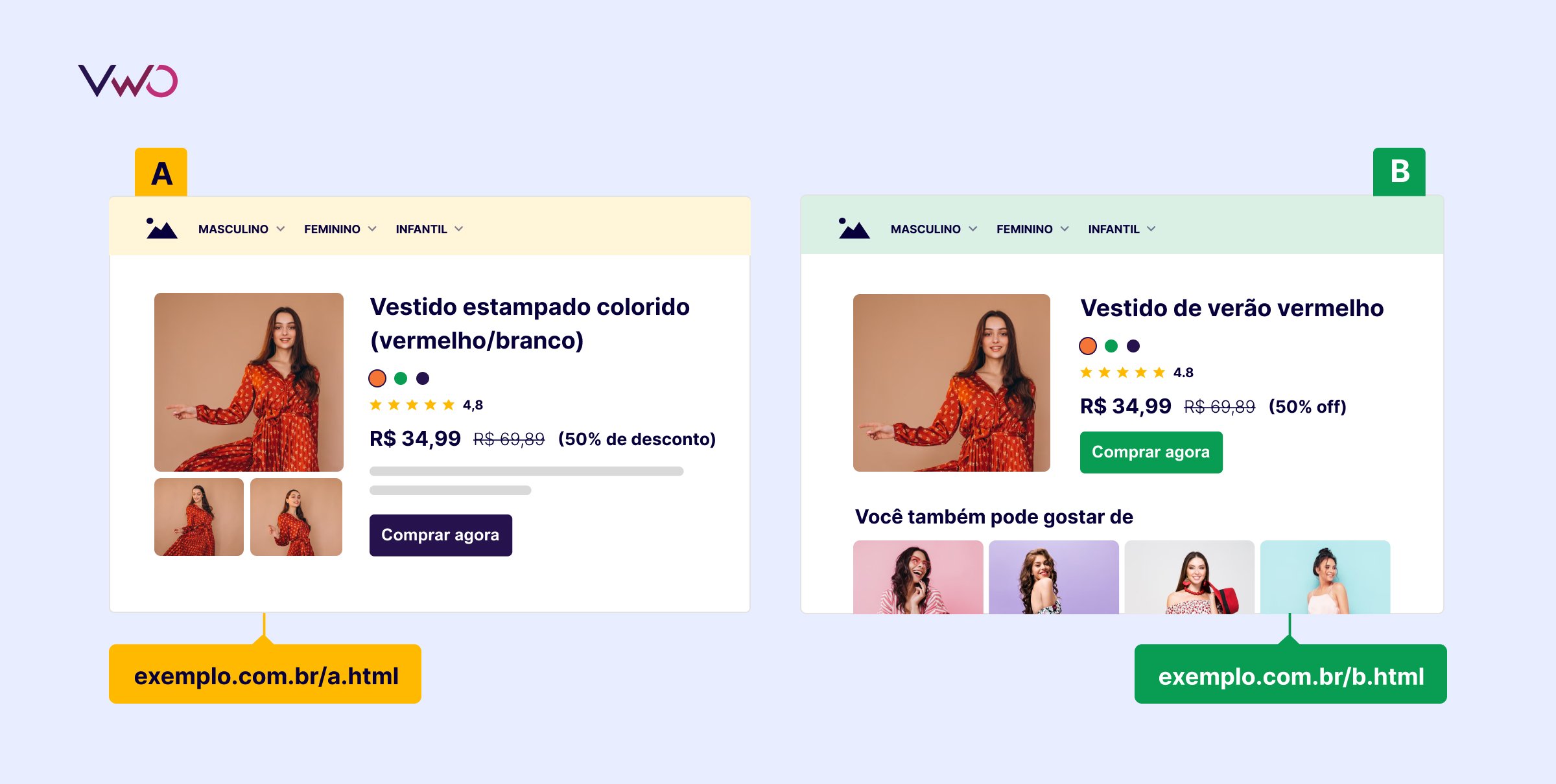

Teste dividido (split test)

Muitas pessoas utilizam os termos “teste A/B” e “teste dividido“ (“split test”, em inglês) como sinônimos. No entanto, eles têm algumas diferenças. Teste de URL dividido é um termo que se refere a um processo experimental em que uma versão completamente nova do URL de um site existente é testada para analisar qual versão funciona melhor.

Os testes A/B, por outro lado, comparam diferentes elementos de um site sem criar um URL completamente novo. Os testes A/B costumam ser utilizados para implementar mudanças mais complexas, como a reformulação completa de uma marca.

Testes multivariados

Nos testes multivariados (MVT), as variações de múltiplos elementos são testadas simultaneamente para analisar qual combinação funciona melhor.

Suponha que você queira testar duas versões de uma imagem, a cor de um botão de call to action e o título de uma de suas landing pages. Um teste multivariado criaria automaticamente oito versões da página com todas as combinações possíveis de alterações para determinar qual delas melhora a métrica que está sendo monitorada. Dessa forma, você não precisa configurar as oito páginas manualmente.

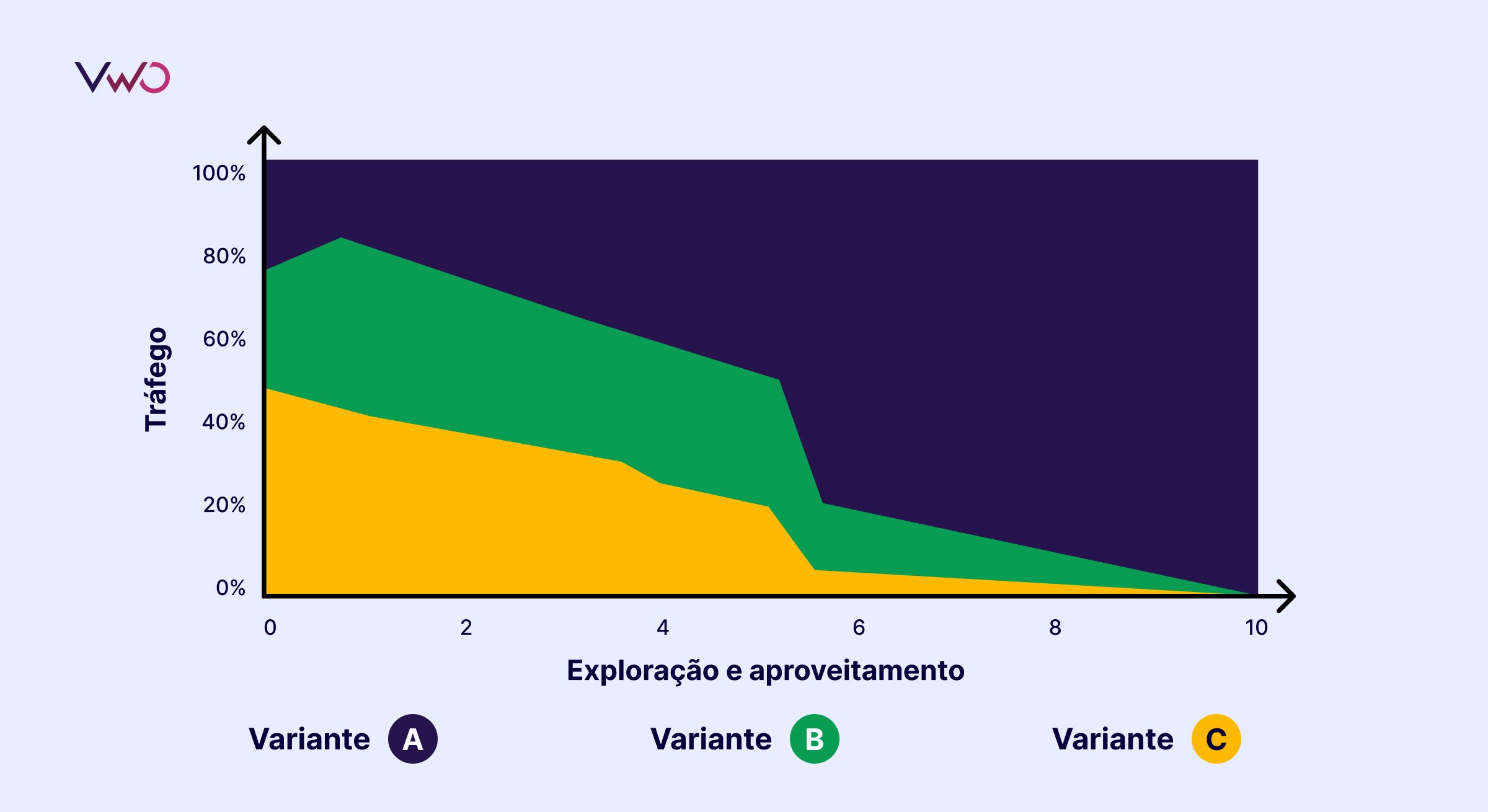

Teste multi-armed bandit

Comparado a um teste A/B convencional, um teste multi-armed bandit não exige que você espere até o final do experimento para direcionar o tráfego para a versão vencedora. Nesta abordagem, os visitantes são atribuídos de forma dinâmica e crescente à versão que apresenta mais conversões.

Testes A/A

Em um teste A/A, um elemento de duas páginas idênticas é comparado. Em vez de determinar um aumento nas conversões, o objetivo do teste A/A é verificar se não há diferença entre a versão de controle e sua variante. Talvez você esteja se perguntando qual é o seguinte de fazer um experimento como esse. Os testes A/A são frequentemente utilizados para avaliar o funcionamento da ferramenta de teste A/B ou identificar erros que possam afetar os resultados dos testes A/B.

Testes de funcionalidades

Os testes de funcionalidade são realizados quando uma nova funcionalidade é implementada em uma aplicação ou quando uma funcionalidade existente é modificada. Eles também podem ser definidos como um processo no qual várias iterações da funcionalidade são testadas para determinar qual versão proporciona a melhor experiência ao usuário.

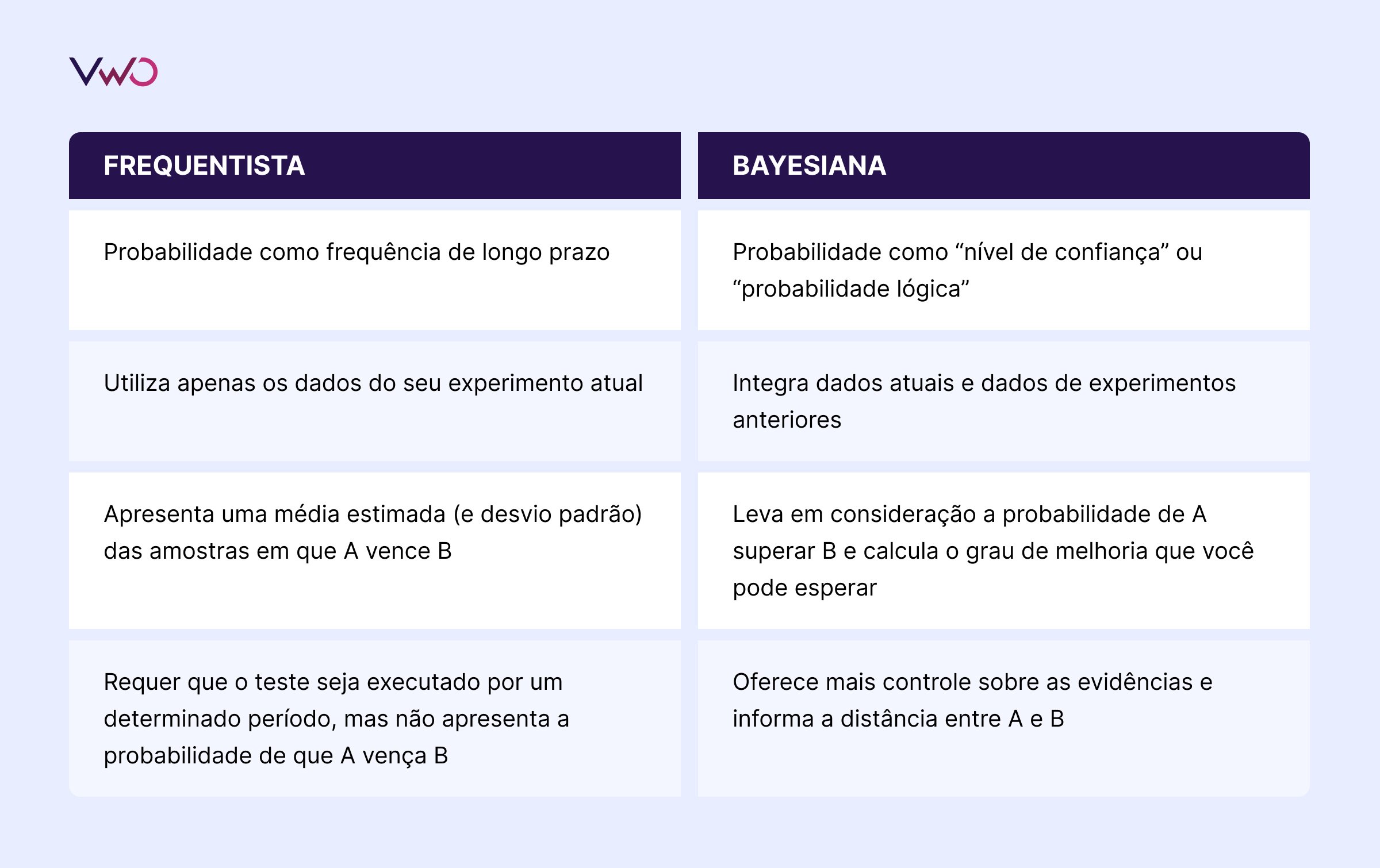

7. Qual abordagem estatística é utilizada em um teste A/B?

É importante saber qual abordagem estatística você deve escolher para realizar um teste A/B bem-sucedido e tirar as conclusões corretas.

Em geral, duas abordagens estatísticas são usadas nos testes A/B: frequentista e bayesiana. Ambas têm vantagens e desvantagens. Na VWO, utilizamos e recomendamos a metodologia bayesiana.

Veja a comparação a seguir das duas abordagens e você vai entender o motivo.

8. Como funciona o processo de um teste A/B?

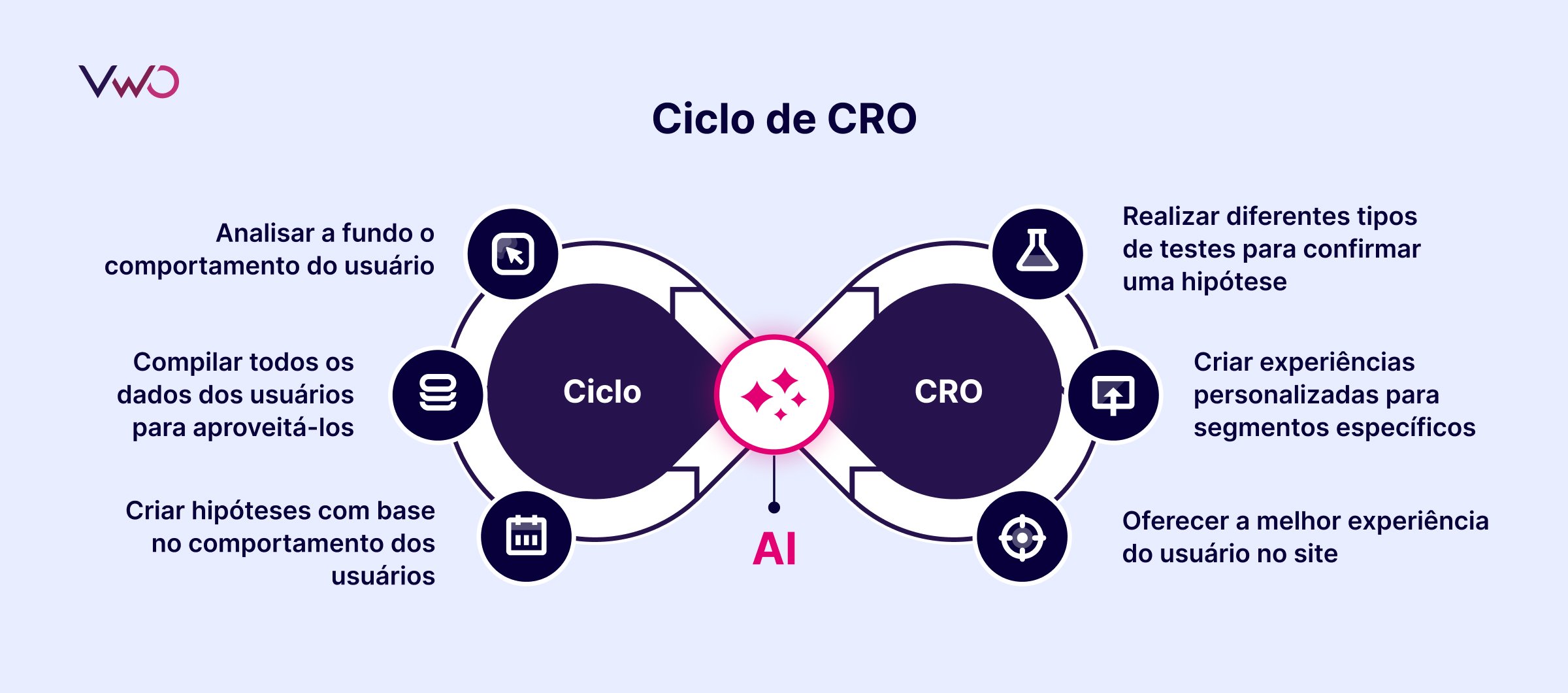

O teste A/B nunca deve ser considerado uma iniciativa isolada de otimização. Ele faz parte de um ciclo de CRO amplo e holístico, e deve ser tratado como tal. O processo de um teste A/B ou ciclo CRO eficaz costuma ser composto por seis fases.

1. Analisar a fundo o comportamento do usuário

Esta é a fase de planejamento do seu programa de testes A/B. Ela se baseia em mensurar o desempenho do seu site e a forma como os visitantes respondem a ele. Nessa etapa, você deve descobrir o que está acontecendo com seu site, por que está acontecendo e como os visitantes estão reagindo. Ferramentas como heatmaps, gravações de sessões e pesquisas são essenciais.

2. Compilar todos os dados dos usuários para aproveitá-los

Após coletar os dados, é hora de registrar as observações e começar a planejar sua campanha. Dados melhores geram mais vendas.

Quando os objetivos empresariais forem definidos, os KPIs fixados e os dados do site e o comportamento dos visitantes analisados, é hora de criar um backlog. Ele deve ser uma lista abrangente de todos os elementos do site que você deseja testar, tomando como base os dados analisados.

3. Criar hipóteses

Comece a criar hipóteses baseadas nos dados. Por exemplo, suponha que você esteja analisando os dados coletados na primeira fase usando ferramentas de pesquisa quantitativa e qualitativa. A conclusão é que a falta de opções de pagamento faz com que a maioria dos clientes abandone o processo de compra na página de pagamento. Assim, você cria a hipótese de que “adicionar múltiplas opções de pagamento ajudará a reduzir a taxa de abandono na página de pagamento.”

Para priorizar suas hipóteses, você pode usar a estrutura CIE. Neste contexto, existem três parâmetros pelos quais você deve qualificar seu teste em uma escala de 1 a 5:

Confiança (“Confidence”): até que ponto você confia que conseguirá atingir a melhoria esperada com a hipótese?

Importância (“Importance”): qual é o nível de importância do teste para o qual foi criada uma hipótese?

Facilidade (“Ease”): qual é o nível de dificuldade para aplicar as mudanças identificadas para o teste?

Se você não tiver ideias durante esta fase, não se preocupe. Com a VWO, é possível receber ideias de testes geradas por IA.

4. Realizar diferentes tipos de testes para confirmar uma hipótese

A quarta e mais importante fase é a realização dos testes. Você já tem todos os dados necessários e um backlog priorizado. Após formular hipóteses que se ajustem ao seu objetivo e priorizá-las, crie variações e comece a executar os testes. Durante esta fase, certifique-se de que todos os requisitos sejam atendidos para obter resultados estatisticamente significativos até a conclusão. Por exemplo, ter o tráfego adequado, não testar muitos elementos ao mesmo tempo, realizar o teste com uma duração adequada, entre outros fatores.

5. Criar experiências personalizadas para segmentos específicos

Ao analisar os resultados dos testes, é importante observar o comportamento dos diferentes segmentos de usuários. Uma variante pode ter sido a perdedora no contexto geral, mas, dentre os usuários de smartphones, ela foi um sucesso. Essa é uma oportunidade para personalizar a experiência para esse grupo de usuários.

6. Oferecer a melhor experiência do usuário no seu site

A análise dos resultados é extremamente importante. Como os testes A/B requerem coleta e análise contínuas de dados, esta etapa implica em avaliar toda a sua campanha. Uma vez que o teste for finalizado, analise os resultados levando em consideração métricas como porcentagem de aumento, nível de confiança e impacto direto e indireto sobre outras métricas. Se o teste for bem-sucedido, implemente a variante vencedora, tomando como base esses números. Se o teste não apresentar uma versão claramente superior, tire conclusões dele e aplique-as em seus próximos testes.

9. Erros comuns nos testes A/B

O teste A/B é uma das formas mais eficazes de impulsionar as métricas das empresas e aumentar sua receita. No entanto, como já vimos, ele requer planejamento, paciência e precisão. Pequenos erros podem resultar em desperdício de tempo e dinheiro. Para evitar que isso aconteça, vamos analisar uma lista dos erros mais comuns que podem ocorrer na realização de um teste A/B:

1º Erro: Não ter um roadmap de testes

Um roadmap de testes eficaz começa com hipóteses sólidas. Todos os passos seguintes dependem delas: o que precisa ser modificado, por que precisa ser modificado, qual é o resultado esperado e assim por diante. Se você começar com uma hipótese errada, a probabilidade de que o teste tenha sucesso diminuirá consideravelmente.

É normal se sentir tentado a testar somente as mudanças que funcionaram para outras pessoas. Pode até ser que alguém tenha alterado o procedimento de cadastro em seu site e atingido um aumento de 30% nas conversões, mas esse foi o resultado de um teste baseado no tráfego, hipótese e objetivos daquela pessoa. Não existem duas páginas web iguais, portanto, o que funciona para os outros pode não funcionar para você. Afinal, o tráfego é diferente, o público-alvo pode ser distinto e cada método de otimização tem suas peculiaridades.

2º Erro: Duração incorreta dos testes

Para alcançar a significância estatística, você deve executar seus testes A/B por um período determinado de acordo com o tráfego e o objetivo. Um teste muito longo ou muito curto pode falhar ou produzir resultados insignificantes. Se uma versão do seu site apresentar melhor desempenho nos primeiros dias após o início do teste, não significa que você deve interrompê-lo antes do período estipulado. Executar uma campanha durante muito tempo também é um erro comum. A duração do teste depende de vários fatores, como tráfego existente, taxa de conversão atual, melhoria esperada, entre outros.

Descubra qual deve ser o tempo de duração do seu teste.

3º Erro: Utilizar a ferramenta errada

À medida que os testes A/B se popularizaram, diversas ferramentas surgiram no mercado com os mais variados preços. Nem todas têm a mesma qualidade. Algumas delas desaceleram drasticamente as suas páginas, enquanto outras não oferecem as funcionalidades necessárias (como heatmaps e gravações de sessões) para garantir os resultados dos seus testes.

4º Erro: Ignorar fatores externos

Para obter resultados significativos, os testes devem ser realizados em períodos comparáveis. Por exemplo, as lojas on-line sabem da diferença entre o tráfego fora de temporada (normal) e na época próxima ao Natal (muito alto). O mesmo teste produziria resultados diferentes e provavelmente falsos se fosse realizado nesses períodos, devido ao fator externo do Natal. Utilize a calculadora de significância de testes A/B da VWO para descobrir se os resultados do seu teste são significativos ou não.

5º Erro: Não seguir um processo iterativo

Os testes A/B são um processo iterativo em que cada novo experimento se baseia nos resultados do anterior. Muitas organizações abandonam o método se o primeiro teste não produz os resultados desejados. No entanto, para aumentar as chances de sucesso, você deve usar os resultados dos testes anteriores para planejar e executar o próximo. Essa abordagem aumenta a probabilidade de que o seu teste gere resultados estatisticamente significativos.

Além disso, você não deve parar seus experimentos quando uma campanha for bem-sucedida. Teste cada elemento diversas vezes para encontrar versões cada vez melhores.

10. Testes A/B e SEO

O Google esclareceu o impacto de SEO sobre os testes A/B em um artigo em seu blog intitulado “Minimizar o impacto de testes A/B na Pesquisa Google”. Aqui, resumimos os pontos mais importantes:

A prática de cloaking é proibida

A prática de cloaking (exibir um conjunto de conteúdo aos usuários humanos e outro ao Googlebot) vai contra as diretrizes, independentemente se você estiver realizando um teste ou não. Certifique-se de não usar o agente do usuário para decidir se ele deve realizar o teste ou qual variante de conteúdo será exibida. Um exemplo disso seria sempre apresentar o conteúdo original quando você notar o agente de usuário “Googlebot”. Lembre-se de que infringir as diretrizes pode fazer com que sua página web perca a classificação ou até mesmo seja removida dos resultados de pesquisa do Google, algo que você não deseja em seu teste.

Utilize apenas redirecionamentos 302

Se você estiver realizando um teste A/B no qual os usuários são redirecionados do URL original para um URL de variação, use o redirecionamento 302 (temporário), não o 301 (permanente). Isso indica aos mecanismos de busca que esse redirecionamento existirá apenas até que você finalize seu experimento e que eles devem manter o URL original indexado, em vez de substituí-lo pela página de teste. O Google também aprova redirecionamentos baseados em JavaScript.

Realize os experimentos durante o tempo adequado

O tempo necessário para realizar um teste confiável depende de vários fatores, como suas taxas de conversão e o tráfego do seu site. Uma boa ferramenta de testes deve indicar quando dados suficientes já foram coletados para tirar conclusões confiáveis. Depois de concluir o teste, atualize sua página com as variantes desejadas e elimine todos os elementos do teste o mais rápido possível, como URLs alternativos ou scripts de teste e marcação.

Utilize links rel=“canonical”

O Google recomenda usar o atributo de link rel=“canonical” em todos os URLs alternativos, para que você consiga destacar que o URL original é o preferido. Essa sugestão se baseia no fato de que rel=“canonical” se adapta melhor à sua intenção nesta situação em comparação com outros métodos, como o uso da meta tag “no index”. Por exemplo, se estiver testando variantes da sua página de produto, você não quer que os mecanismos de pesquisa façam a indexação dela. Seu desejo é que eles entendam que todos os URLs de teste são duplicatas próximas ou variantes do URL original e, por isso, devem ser agrupados, mantendo a versão original em primeiro plano. Nesses casos, usar “no index” em vez de rel=“canonical” pode ter efeitos negativos e inesperados.

11. Ferramentas de testes A/B

O mercado de ferramentas de testes A/B cresceu muito nos últimos anos. Listamos algumas das opções mais populares. Você encontra nossa comparação de todas as funcionalidades em uma publicação no nosso blog.

1. VWO

2. Google Optimize (Não está mais disponível, mas migrar para a VWO leva apenas 30 segundos)

3. Optimizely

4. AB Tasty

5. Adobe Target

6. Dynamic Yield

7. Kameleoon

Conclusão: Faça o teste

Se você chegou até aqui, já é praticamente um especialista em testes A/B. Mas, como em muitas outras disciplinas, essa é uma arte que se aperfeiçoa com a prática. Talvez você já tenha algumas ideias que gostaria de experimentar ou este artigo tenha trazido alguma inspiração para tentar algo novo. De qualquer forma, adoraríamos mostrar como é fácil colocar suas ideias em prática com a VWO. Cadastre-se em nosso teste gratuito ou permita-nos mostrar a plataforma em uma demonstração. Buscando mais inspiração? Baixe nosso e-book “O que os usuários esperam das lojas on-line” e encontre sua próxima ideia para executar um teste A/B. Você consegue!

Perguntas frequentes sobre testes A/B

Teste A/B é o processo de comparação de duas versões de um mesmo elemento de uma página web. Normalmente, isso é feito para verificar como os visitantes reagem à variação A e à variação B e, assim, decidir qual delas é a mais eficaz.

No setor do marketing digital, o teste A/B é o processo pelo qual duas versões da mesma página web são apresentadas a diferentes segmentos de visitantes ao mesmo tempo, para comparar qual delas gera mais conversões.

Existem diversos motivos pelos quais as empresas realizam testes A/B, como resolver pontos de atrito dos visitantes, aumentar as conversões e leads, reduzir a taxa de rejeição, entre outros. Leia nosso guia para conhecer todos os motivos em maiores detalhes.

Nos testes A/B, o tráfego é dividido em duas ou mais versões completamente diferentes de uma página web. Já os testes multivariáveis abrangem múltiplas combinações de determinados elementos-chave de uma página, que são comparados entre si para saber qual deles funciona melhor para atingir o objetivo definido.